автордың кітабын онлайн тегін оқу Производительность систем

Переводчик А. Киселев

Брендан Грегг

Производительность систем. — СПб.: Питер, 2023.

ISBN 978-5-4461-1818-2

© ООО Издательство "Питер", 2023

Все права защищены. Никакая часть данной книги не может быть воспроизведена в какой бы то ни было форме без письменного разрешения владельцев авторских прав.

Посвящается Дейрдре Страуган, удивительному специалисту и удивительному человеку, — мы сделали это!

Предисловие

Есть известные известные — вещи, о которых мы знаем, что знаем их. Есть также известные неизвестные — вещи, о которых мы знаем, что не знаем. Но еще есть неизвестные неизвестные — это вещи, о которых мы не знаем, что не знаем их.

Министр обороны США Дональд Рамсфельд, 12 февраля 2002 г.

Это заявление на пресс-брифинге встретили с усмешками. Однако оно определяет принцип, одинаково важный и для сложных технических систем, и для геополитики: проблемы с эффективностью могут возникать где угодно, включая те области системы, о которых вы ничего не знаете и поэтому не проверяете (неизвестные неизвестные). Эта книга поможет раскрыть многие из таких областей, а также предоставит методики и инструменты для их анализа.

Об этом издании

Первое издание я написал восемь лет назад и рассчитывал, что оно будет актуально достаточно долго. Главы структурированы так, чтобы сначала охватить то, что постоянно (модели, архитектуры и методологии), а затем то, что быстро меняется (инструменты и настройки). Инструменты и приемы настройки устаревают, но знание базовых вещей поможет всегда оставаться в курсе последних изменений.

За последние восемь лет в Linux появилось большое дополнение: Extended BPF — технология ядра, которая поддерживает новое поколение инструментов анализа производительности и используется в Netflix и Facebook. В это новое издание я включил главу о BPF и инструментах BPF, а также опубликовал подробный справочник по BPF [Gregg 19]. Инструменты perf и Ftrace в ОС Linux также претерпели множество изменений, и я добавил для них отдельные главы. Ядро Linux получило множество новых технологий и параметров оценки производительности, которые тоже рассматриваются в этом издании книги. Гипервизоры, управляющие облачными виртуальными машинами, и контейнерные технологии тоже существенно изменились, и главы, посвященные им, были обновлены и дополнены.

Первое издание в равной степени охватывало Linux и Solaris. Однако доля рынка Solaris за эти годы сильно сократилась [ITJobsWatch 20], поэтому я почти полностью убрал из этого издания все, что касалось Solaris, освободив место для дополнительной информации о Linux. Но как мне кажется, возможность сравнения с альтернативами укрепит общее понимание операционной системы или ядра. По этой причине я включил в это издание некоторые упоминания о Solaris и других ОС.

Последние шесть лет я работал старшим перформанс-инженером в Netflix, используя свои знания для оценки производительности микросервисов в Netflix и устранения проблем. Я занимался вопросами производительности гипервизоров, контейнеров, библиотек, ядер, баз данных и приложений. По мере необходимости я разрабатывал новые методологии и инструменты и обменивался опытом с экспертами в области производительности облачных систем и разработки ядра Linux. Все это в немалой степени улучшило второе издание книги.

Об этой книге

Итак, добро пожаловать во второе издание «Производительности систем»! Книга посвящена производительности (performance) ОС и приложений в контексте операционной системы и охватывает корпоративные серверы и облачные среды. Большая часть информации из книги может пригодиться также для анализа производительности клиентских устройств и ОС настольных компьютеров. Моя цель — помочь вам получить максимальную отдачу от ваших систем, какими бы они ни были.

При работе с прикладным программным обеспечением, находящимся в постоянном развитии, может возникнуть соблазн думать об эффективности ОС, ядро которой разрабатывалось и настраивалось десятилетиями, как о решенной проблеме. Но это не так! Операционная система — это сложный комплекс ПО, управляющего множеством постоянно меняющихся физических устройств и различными прикладными рабочими нагрузками. Ядра тоже находятся в постоянном развитии, в них добавляются новые возможности увеличения производительности определенных рабочих нагрузок, а вновь возникающие узкие места устраняются по мере масштабирования системы. Изменения в ядре, например, устраняющие уязвимость Meltdown и представленные в 2018 году, тоже могут отрицательно сказываться на производительности. Анализ и работа над улучшением производительности ОС — это непрерывный процесс. Производительность приложений тоже можно проанализировать в контексте операционной системы, чтобы отыскать подсказки, которые можно упустить при использовании только инструментов для приложений; об этом я тоже расскажу.

Рассматриваемые операционные системы

Эта книга изучает производительность систем. В роли основного представителя выступают ОС на базе Linux для процессоров Intel. Но книга организована так, чтобы вы могли изучить и другие ядра для других аппаратных архитектур.

Для представленных примеров конкретный дистрибутив Linux не важен, если явно не указано иное. Основная масса примеров была получена в дистрибутиве Ubuntu, и там, где это важно, в текст включены примечания, объясняющие отличия от других дистрибутивов. В книге приводятся примеры, полученные в системах различных типов: без операционной системы (на «голом железе») и в виртуальных средах, на производственных и тестовых машинах, на серверах и клиентских устройствах.

В своей работе я сталкивался со множеством разных операционных систем и ядер, что углубило мое понимание их дизайна. Чтобы вы могли во всем разобраться, в книгу включены некоторые упоминания о Unix, BSD, Solaris и Windows.

Другие материалы

Примеры скриншотов инструментов анализа производительности включены не только чтобы показать данные, но и для иллюстрации видов доступных данных. Инструменты часто представляют данные простым и понятным способом, многие из них реализованы в стиле, знакомом по более ранним инструментам для Unix. Учитывая это, скриншоты могут быть мощным средством показать назначение этих инструментов почти без дополнительного описания. (Если инструмент требует подробного объяснения, это может быть признаком неудачного дизайна.)

Там, где это уместно, я затрагиваю историю появления определенных технологий. Также полезно узнать немного о ключевых людях в этой отрасли: вы наверняка сталкивались с ними или их работой в сфере эффективности и в других контекстах. Их имена вы найдете в приложении E.

Некоторые темы, рассматриваемые в этом издании, также были освещены в моей предыдущей книге, «BPF Performance Tools»1 [Gregg 19]: в частности, BPF, BCC, bpftrace, tracepoints, kprobes, uprobes и множество других инструментов на основе BPF. В этой книге вы найдете дополнительную информацию. Краткое изложение этих тем здесь часто основано на той, более ранней книге. Иногда я использую тот же текст и примеры.

О чем здесь не рассказывается

Эта книга посвящена производительности. Для выполнения всех приведенных примеров потребуются некоторые действия по администрированию системы, включая установку или компиляцию программного обеспечения (которые здесь не рассматриваются).

Также здесь кратко описывается внутреннее устройство операционной системы, которое более подробно рассматривается в специализированных изданиях. Вопросы, касающиеся углубленного анализа производительности, здесь рассмотрены в общих чертах — лишь для того, чтобы вы знали об их существовании и могли заняться их изучением по другим источникам. См. раздел «Дополнительные источники, ссылки и библиография» в конце предисловия.

Структура

Глава 1 «Введение» — это введение в анализ производительности системы. Глава обобщает ключевые идеи и приводит примеры действий, направленных на улучшение производительности.

Глава 2 «Методологии» формирует основу для анализа и настройки производительности и описывает терминологию, основные понятия, модели, методологии для наблюдения и экспериментов, планирование емкости, анализ и статистику.

Глава 3 «Операционные системы» описывает внутреннее устройство ядра с точки зрения анализа производительности. Глава закладывает основы, необходимые для интерпретации и понимания действий операционной системы.

Глава 4 «Инструменты наблюдения» знакомит с доступными средствами наблюдения за системой, а также интерфейсами и фреймворками, на которых они построены.

Глава 5 «Приложения» обсуждает вопросы производительности приложений и наблюдение за ними из операционной системы.

Глава 6 «Процессоры» рассматривает процессоры, ядра, аппаратные потоки выполнения, кэш-память процессора, взаимосвязи между процессорами, взаимосвязи между устройствами и механизмы планирования в ядре.

Глава 7 «Память» посвящена виртуальной памяти, страничной организации, механизму подкачки, архитектурам памяти, шинам, адресным пространствам и механизмам распределения памяти.

Глава 8 «Файловые системы» посвящена производительности операций ввода/вывода с файловой системой, включая различные механизмы кэширования.

Глава 9 «Диски» описывает устройства хранения, рабочие нагрузки дискового ввода/вывода, контроллеры хранилищ, дисковые массивы RAID и подсистему ввода/вывода ядра.

Глава 10 «Сеть» посвящена сетевым протоколам, сокетам, интерфейсам и физическим соединениям.

Глава 11 «Облачные вычисления» знакомит с методами виртуализации операционных систем и оборудования, которые обычно используются для организации облачных вычислений, а также с их характеристиками производительности, изоляции и наблюдаемости. В этой главе также рассматриваются гипервизоры и контейнеры.

Глава 12 «Бенчмаркинг» показывает, как правильно проводить сравнительный анализ и как интерпретировать результаты бенчмаркинга. Это на удивление сложная тема, и в этой главе я покажу, как избежать типичных ошибок, и попробую объяснить их смысл.

Глава 13 «perf» кратко описывает стандартный профилировщик Linux, perf(1), и его многочисленные возможности. Ссылки на этот справочник по perf(1) вы будете встречать по всей книге.

Глава 14 «Ftrace» кратко описывает стандартное средство трассировки Linux, Ftrace, которое особенно подходит для исследования особенностей работы ядра.

Глава 15 «BPF» кратко описывает стандартные внешние интерфейсы BPF: BCC и bpftrace.

Глава 16 «Пример из практики» содержит пример исследования производительности системы, проводившегося в Netflix. Он показывает, как проводился анализ производительности.

Главы 1–4 содержат важную базовую информацию. Прочитав их, вы будете готовы перейти к любой из остальных глав в книге, в частности к главам 5–12, в которых рассматриваются конкретные цели для анализа.

Главы 13–15 посвящены продвинутому профилированию и трассировке и являются факультативным чтением для тех, кто хочет подробнее изучить один или несколько трассировщиков.

В главе 16 я привожу истории, которые позволят сформировать более широкое представление о работе перформанс-инженера. Если вы только начинаете заниматься анализом производительности, то можете прочитать сначала эту главу. Она покажет пример анализа производительности с использованием множества различных инструментов. Вы можете вернуться к ней после прочтения других глав.

Применимость в будущем

Я писал эту книгу так, чтобы ее полезность сохранялась на долгие годы. Основное внимание в ней уделяется опыту и методологиям анализа производительности систем.

Для этого многие главы были разделены на две части. Первая часть включает определения, описание понятий и методологий (часто соответствующие разделы именно так и называются), которые должны оставаться актуальными на протяжении многих лет. Во второй части приводятся примеры реализации: архитектура, инструменты анализа и настраиваемые параметры. Они могут устареть, но все же останутся полезными в качестве примеров.

Примеры трассировки

Часто требуется глубоко изучить операционную систему, чтобы знать, что можно сделать с помощью инструментов трассировки.

Уже после выхода первого издания была разработана и внедрена в ядро Linux расширенная технология BPF, в результате чего появилось новое поколение инструментов трассировки, использующих внешние интерфейсы BCC и bpftrace. Эта книга посвящена BCC и bpftrace, а также встроенному в ядро Linux трассировщику Ftrace. BPF, BCC и bpftrace более подробно описаны в моей предыдущей книге [Gregg 19].

В книге рассматривается еще один инструмент трассировки Linux — perf. Но perf здесь в основном используется для получения и анализа счетчиков контроля производительности (performance monitoring counter, PMC), а не для трассировки.

Возможно, вы захотите использовать другие инструменты трассировки, и это нормально. Представленные в этой книге инструменты показывают, какие вопросы можно задать системе. Часто именно эти вопросы и методологии, которые их ставят, труднее всего понять.

Для кого эта книга

В первую очередь книга адресована системным администраторам и операторам корпоративных и облачных вычислительных сред. Она послужит справочником для разработчиков, администраторов баз данных и администраторов веб-серверов, которые должны понимать, из чего складывается производительность операционных систем и приложений.

Как перформанс-инженеру в компании с гигантской вычислительной инфраструктурой (Netflix), мне часто приходится работать с SRE-инженерами и разработчиками, которым просто физически не хватает времени для решения сразу нескольких проблем с производительностью. Мне тоже доводилось работать дежурным инженером в Netflix CORE SRE, и я знаком с этой нехваткой времени на собственном опыте. Для многих людей обеспечение производительности не является их основной работой, и им достаточно знать ровно столько, чтобы решать текущие проблемы. Я понимаю, что у вас может быть мало времени, и я постарался сделать эту книгу как можно короче и проще по структуре.

Другая целевая аудитория — студенты. Книга поможет при изучении курса производительности систем. Я вел подобные курсы раньше и знаю, что лучше всего помогает студентам решать проблемы с успеваемостью. Этими знаниями я руководствовался при работе над книгой.

Кем бы вы ни были, упражнения в главах позволят проверить себя и надежнее усвоить материал. Среди них вы найдете особенно сложные упражнения, которые необязательно решать. (Они могут представлять проблемы, не имеющие решения, главная их цель — заставить задуматься.)

Наконец, с точки зрения размера компании эта книга содержит достаточно подробностей, чтобы удовлетворить потребности компаний от мала до велика. Для многих небольших компаний эта книга послужит справочником, в котором лишь некоторые части используются ежедневно.

Условные обозначения

В этой книге используются следующие условные обозначения:

| Пример |

Описание |

| netif_receive_skb() |

Имя функции |

| iostat(1) |

Команда со ссылкой на раздел в справочном руководстве man с ее описанием |

| read(2) |

Системный вызов со ссылкой на раздел в справочном руководстве man с его описанием |

| malloc(3) |

Имя функции из библиотеки языка C со ссылкой на раздел в справочном руководстве man с ее описанием |

| vmstat(8) |

Команда администрирования со ссылкой на раздел в справочном руководстве man с ее описанием |

| Documentation/... |

Каталог с документацией в дереве исходных текстов ядра Linux |

| kernel/... |

Каталог в дереве исходных текстов ядра Linux |

| fs/... |

Каталог с реализацией файловой системы в дереве исходных текстов ядра Linux |

| CONFIG_... |

Параметры настройки ядра Linux (Kconfig) |

| r_await |

Команда в командной строке и ее вывод |

| mpstat 1 |

Команда или ключевая деталь, на которую следует обратить особое внимание |

| # |

Приглашение к вводу в командной оболочке суперпользователя (root) |

| $ |

Приглашение к вводу в командной оболочке обычного пользователя (не root) |

| ^C |

Прерывание выполнения команды (комбинацией клавиш Ctrl-C) |

| [...] |

Усечение |

Дополнительные источники, ссылки и библиография

Список литературы приводится в конце каждой главы, а не в конце всей книги. Вы сразу можете смотреть источники, относящиеся к теме каждой главы. В списке ниже перечислены книги, из которых можно почерпнуть информацию об ОС и анализе производительности:

[Jain 91] Jain, R., «The Art of Computer Systems Performance Analysis: Techniques for Experimental Design, Measurement, Simulation, and Modeling», Wiley, 1991.

[Vahalia 96] Vahalia, U., «UNIX Internals: The New Frontiers», Prentice Hall, 1996.2

[Cockcroft 98] Cockcroft, A., and Pettit, R., «Sun Performance and Tuning: Java and the Internet, Prentice Hall», 1998.

[Musumeci 02] Musumeci, G.D., and Loukides, M., «System Performance Tuning, 2nd Edition», O’Reilly, 2002.3

[Bovet 05] Bovet, D., and Cesati, M., «Understanding the Linux Kernel, 3rd Edition», O’Reilly, 2005.4

[McDougall 06a] McDougall, R., Mauro, J., and Gregg, B., «Solaris Performance and Tools: DTrace and MDB Techniques for Solaris 10 and OpenSolaris», Prentice Hall, 2006.

[Gove 07] Gove, D., «Solaris Application Programming», Prentice Hall, 2007.

[Love 10] Love, R., «Linux Kernel Development, 3rd Edition», Addison-Wesley, 2010.5

[Gregg 11a] Gregg, B., and Mauro, J., «DTrace: Dynamic Tracing in Oracle Solaris, Mac OS X and FreeBSD», Prentice Hall, 2011.

[Gregg 13a] Gregg, B., «Systems Performance: Enterprise and the Cloud», Prentice Hall, 2013 (first edition).

[Gregg 19] Gregg, B., «BPF Performance Tools: Linux System and Application Observability»6, Addison-Wesley, 2019.

[ITJobsWatch 20] ITJobsWatch, «Solaris Jobs», https://www.itjobswatch.co.uk/jobs/uk/solaris.do#demand_trend, ссылка была действительна в феврале 2021.

1 Грегг Б. «BPF: Профессиональная оценка производительности». Выходит в издательстве «Питер» в 2023 году.

2 Вахалия Ю. «UNIX изнутри». СПб.: Издательство «Питер».

3 Мусумеси Дж.-П. Д. Лукидес М. «Настройка производительности UNIX-систем».

4 Бовет Д., Чезати М. «Ядро Linux».

5 Лав Р. «Ядро Linux. Описание процесса разработки».

6 Грегг Б. «BPF: Профессиональная оценка производительности». Выходит в издательстве «Питер» в 2023 году.

Некоторые темы, рассматриваемые в этом издании, также были освещены в моей предыдущей книге, «BPF Performance Tools»1 [Gregg 19]: в частности, BPF, BCC, bpftrace, tracepoints, kprobes, uprobes и множество других инструментов на основе BPF. В этой книге вы найдете дополнительную информацию. Краткое изложение этих тем здесь часто основано на той, более ранней книге. Иногда я использую тот же текст и примеры.

[Love 10] Love, R., «Linux Kernel Development, 3rd Edition», Addison-Wesley, 2010.5

[Gregg 19] Gregg, B., «BPF Performance Tools: Linux System and Application Observability»6, Addison-Wesley, 2019.

[Musumeci 02] Musumeci, G.D., and Loukides, M., «System Performance Tuning, 2nd Edition», O’Reilly, 2002.3

[Vahalia 96] Vahalia, U., «UNIX Internals: The New Frontiers», Prentice Hall, 1996.2

[Bovet 05] Bovet, D., and Cesati, M., «Understanding the Linux Kernel, 3rd Edition», O’Reilly, 2005.4

Лав Р. «Ядро Linux. Описание процесса разработки».

Бовет Д., Чезати М. «Ядро Linux».

Грегг Б. «BPF: Профессиональная оценка производительности». Выходит в издательстве «Питер» в 2023 году.

Грегг Б. «BPF: Профессиональная оценка производительности». Выходит в издательстве «Питер» в 2023 году.

Мусумеси Дж.-П. Д. Лукидес М. «Настройка производительности UNIX-систем».

Вахалия Ю. «UNIX изнутри». СПб.: Издательство «Питер».

Благодарности

Спасибо всем купившим первое издание, и особенно тем, кто рекомендовал прочитать его своим коллегам. Поддержка первой книги способствовала созданию второй. Спасибо вам.

Это моя последняя книга, посвященная производительности систем, но не первая. Я хотел бы поблагодарить авторов других книг по этой же тематике, на которые я опирался и на которые неоднократно ссылаюсь здесь. В частности, хотел бы поблагодарить Адриана Кокрофта (Adrian Cockcroft), Джима Мауро (Jim Mauro), Ричарда Макдугалла (Richard McDougall), Майка Лукидеса (Mike Loukides) и Раджа Джейна (Raj Jain). Все вы здорово помогли мне, и я надеюсь, что смогу помочь вам.

Я благодарен всем, кто давал мне обратную связь:

Дейрдра Страуган (Deirdré Straughan) всячески поддерживала меня и использовала свой богатый опыт редактирования технических книг, чтобы каждая страница этой книги стала лучше. Слова, которые вы читаете, принадлежат нам обоим. Нам нравится не только вместе проводить время (сейчас мы женаты), но и работать. Спасибо.

Филиппу Мареку (Philipp Marek) — эксперту в информационных технологиях, ИТ-архитектору и перформанс-инженеру в Австрийском федеральном вычислительном центре. Он одним из первых делился мнением по каждой теме этой книги (настоящий подвиг) и даже обнаружил проблемы в тексте первого издания. Филипп начал программировать в 1983 году, еще для микропроцессора 6502, и практически сразу стал искать способы экономии тактов процессора. Спасибо, Филипп, за твой опыт и неустанную работу!

Дейл Хэмел (Dale Hamel, Shopify) тоже внимательно прочитал каждую главу, предоставил важные сведения о различных облачных технологиях и помог взглянуть на книгу другими глазами. Спасибо тебе, Дейл, что взял на себя этот труд! Это случилось сразу после того, как ты помог мне с книгой о BPF.

Даниэль Боркманн (Daniel Borkmann, Isovalent) тщательно прорецензировал некоторые главы, в частности главы о сетях. Это помогло мне лучше понять имеющиеся сложности и сопутствующие технологии. Даниэль уже много лет занимается сопровождением ядра Linux и обладает огромным опытом работы над сетевым стеком ядра и расширенным BPF. Спасибо тебе, Даниэль, за профессионализм и строгость оценок.

Я особенно благодарен мейнтейнеру инструмента perf Арнальдо Карвалью де Мело (Arnaldo Carvalho de Melo; Red Hat) за помощь с главой 13 «perf» и Стивену Ростедту (Steven Rostedt; VMware), создателю Ftrace, за помощь с главой 14 «Ftrace» — двумя темами, которые я недостаточно полно рассмотрел в первом издании. Я высоко ценю их не только за помощь в написании этой книги, но также за их работу над этими инструментами повышения производительности, которые я использовал для решения бесчисленных проблем в Netflix.

Было очень приятно, что Доминик Кэй (Dominic Kay) пролистал несколько глав и оставил множество советов по улучшению читаемости и повышению технической точности. Доминик также помогал мне с первым изданием (а еще раньше мы вместе работали в Sun Microsystems, где занимались вопросами производительности). Спасибо, Доминик.

Мой нынешний коллега по Netflix, Амер Атер (Amer Ather), оставил очень ценные отзывы к нескольким главам. Амер — инженер, разбирающийся в сложных технологиях. Захарий Джонс (Zachary Jones, Verizon) тоже дал обратную связь по особенно сложным вопросам и поделился опытом в области производительности, чем очень помог улучшить книгу. Спасибо вам, Амер и Захарий.

Несколько рецензентов, взяв несколько глав, участвовали в обсуждении конкретных тем: Алехандро Проаньо (Alejandro Proaño, Amazon), Бикаш Шарма (Bikash Sharma, Facebook), Кори Луенингонер (Cory Lueninghoener, Национальная лаборатория в Лос-Аламосе), Грег Данн (Greg Dunn, Amazon), Джон Аррасджид (John Arrasjid, Ottometric), Джастин Гаррисон (Justin Garrison, Amazon), Майкл Хаузенблас (Michael Hausenblas, Amazon) и Патрик Кейбл (Patrick Cable, Threat Stack). Спасибо всем за вашу помощь и энтузиазм.

Также спасибо Адитье Сарваде (Aditya Sarwade, Facebook), Эндрю Галлатину (Andrew Gallatin, Netflix), Басу Смиту (Bas Smit), Джорджу Невиллу-Нилу (George Neville-Neil, JUUL Labs), Йенсу Аксбоу (Jens Axboe, Facebook), Джоэлю Фернандесу (Joel Fernandes, Google), Рэндаллу Стюарту (Randall Stewart, Netflix), Стефану Эраниану (Stephane Eranian, Google) и Токе Хойланд-Йоргенсену (Toke Høiland-Jørgensen, Red Hat) за ответы на вопросы и своевременную техническую помощь.

Те, кто участвовал в создании моей предыдущей книги — «BPF Performance Tools», тоже косвенно помогли мне, потому что некоторые материалы этого издания основаны на предыдущем. Улучшению той книги в немалой степени способствовали Аластер Робертсон (Alastair Robertson, Yellowbrick Data), Алексей Старовойтов (Alexei Starovoitov, Facebook), Дэниел Боркманн (Daniel Borkmann), Джейсон Кох (Jason Koch, Netflix), Мэри Марчини (Mary Marchini, Netflix), Масами Хирамацу (Masami Hiramatsu, Linaro), Мэтью Дезнойерс (Mathieu Desnoyers, EfficiOS), Йонгхонг Сонг (Yonghong Song, Facebook) и многие другие. Полный список вы найдете в разделе «Благодарности» предыдущего издания.

Многие, помогавшие мне в работе над первым изданием, помогли в работе и над этим. В частности, я получил техническую поддержку по нескольким главам от Адама Левенталя (Adam Leventhal), Карлоса Карденаса (Carlos Cardenas), Дэррила Гоува (Darryl Gove), Доминика Кэя (Dominic Kay), Джерри Елинека (Jerry Jelinek), Джима Мауро (Jim Mauro), Макса Брунинга (Max Bruning), Ричарда Лоу (Richard Lowe) и Роберта Мустаччи (Robert Mustacchi). Я также получил отзывы и поддержку от Адриана Кокрофта (Adrian Cockcroft), Брайана Кантрилла (Bryan Cantrill), Дэна Макдональда (Dan McDonald), Дэвида Пачеко (David Pacheco), Кита Весоловски (Keith Wesolowski), Марселля Кукульевича-Пирса (Marsell Kukuljevic-Pearce) и Пола Эгглтона (Paul Eggleton). Рох Бурбоннис (Roch Bourbonnais) и Ричард Макдугалл (Richard McDougall) многому научили меня на моей предыдущей работе, где мы занимались проблемами производительности, и тем самым оказали косвенную помощь в работе над этой книгой, как и Джейсон Хоффман (Jason Hoffman), косвенно помогавший в работе над первым изданием.

Ядро Linux — сложный и постоянно меняющийся программный продукт, и я ценю труд Джонатана Корбета (Jonathan Corbet) и Джейка Эджа (Jake Edge) из lwn.net по обобщению большого числа сложнейших тем. Многие из их статей упоминаются в этой книге.

Отдельное спасибо Грегу Доенчу (Greg Doench) — выпускающему редактору издательства Pearson за гибкость и поддержку, благодаря которым процесс двигался особенно эффективно. Спасибо продюсеру информационного наполнения Джулии Нахил (Julie Nahil; Pearson) и менеджеру проекта Рэйчел Пол (Rachel Paul) за внимание к деталям и помощь в создании качественного продукта. Спасибо редактору Киму Уимпсетту (Kim Wimpsett) за работу над еще одной из моих длинных и глубоко технических книг, за множество предложений по улучшению текста.

И спасибо тебе, Митчелл, за терпение и понимание.

Начиная с первого издания, я продолжал работать перформанс-инженером, устраняя проблемы по всему программно-аппаратному стеку. Теперь у меня еще больше опыта в работе с гипервизорами, в настройке производительности, в анализе среды выполнения (включая JVM), в применении трассировщиков, включая Ftrace и BPF, а также в реагировании на быстро меняющиеся микросервисы Netflix и ядро Linux. Многое из этого недостаточно хорошо задокументировано, и порой было очень сложно определить, что отразить в книге. Но я люблю сложности.

Об авторе

Брендан Грегг — эксперт в области производительности и облачных вычислений. Работает старшим перформанс-инженером в Netflix, где занимается проектированием, оценкой, анализом и настройкой производительности. Автор нескольких книг, в том числе «BPF Performance Tools7». Обладатель награды USENIX LISA за выдающиеся достижения в системном администрировании. Работал инженером по поддержке ядра, руководил командой обеспечения производительности и профессионально занимался преподаванием технических дисциплин, был сопредседателем конференции USENIX LISA 2018. Создал множество инструментов оценки производительности для разных операционных систем, а также разработал средства и методы визуализации для анализа производительности, включая флейм-графики.

От издательства

Ваши замечания, предложения, вопросы отправляйте по адресу comp@piter.com (издательство «Питер», компьютерная редакция).

Мы будем рады узнать ваше мнение!

На веб-сайте издательства www.piter.com вы найдете подробную информацию о наших книгах.

7 Грегг Б. «BPF: Профессиональная оценка производительности». Выходит в издательстве «Питер» в 2023 году.

Грегг Б. «BPF: Профессиональная оценка производительности». Выходит в издательстве «Питер» в 2023 году.

Брендан Грегг — эксперт в области производительности и облачных вычислений. Работает старшим перформанс-инженером в Netflix, где занимается проектированием, оценкой, анализом и настройкой производительности. Автор нескольких книг, в том числе «BPF Performance Tools7». Обладатель награды USENIX LISA за выдающиеся достижения в системном администрировании. Работал инженером по поддержке ядра, руководил командой обеспечения производительности и профессионально занимался преподаванием технических дисциплин, был сопредседателем конференции USENIX LISA 2018. Создал множество инструментов оценки производительности для разных операционных систем, а также разработал средства и методы визуализации для анализа производительности, включая флейм-графики.

Глава 1. Введение

Производительность компьютеров — увлекательная, многообразная и сложная дисциплина. В этой главе вы познакомитесь с понятием эффективности и производительности систем.

Цели главы:

• познакомить с понятием производительности системы, кто и как ее обеспечивает и какие сложности встречаются на этом пути;

• показать разницу между инструментами наблюдения и инструментами проведения экспериментов;

• дать общее представление о способах и средствах оценки производительности, таких как параметры, профилирование, флейм-графики, трассировка, статические и динамические инструменты;

• представить роль методологий и короткий чек-лист для исследования производительности Linux.

Здесь будут даны ссылки на последующие главы, поэтому данную главу можно считать введением и в дисциплину производительности систем, и в книгу в целом. Глава заканчивается реальными примерами, показывающими, насколько важно уделять внимание производительности систем.

1.1. Производительность системы

Под оценкой производительности системы понимается изучение производительности всей компьютерной системы, включая основные программные и аппаратные компоненты, — все, что находится на пути к данным, от устройств хранения до прикладного программного обеспечения, — потому что все они могут влиять на производительность. В случае с распределенными системами в этот список также входят все серверы и приложения. Если у вас нет схемы вашего окружения, отражающей путь к данным, найдите ее или нарисуйте сами; она поможет увидеть взаимосвязи между компонентами и не упустить из виду целые области.

Типичная цель оценки производительности системы — улучшить взаимодействие с конечным пользователем за счет уменьшения задержек и снижения затрат на вычисления. Снижения затрат можно достигнуть за счет устранения неэффективности, повышения пропускной способности и общей настройки системы.

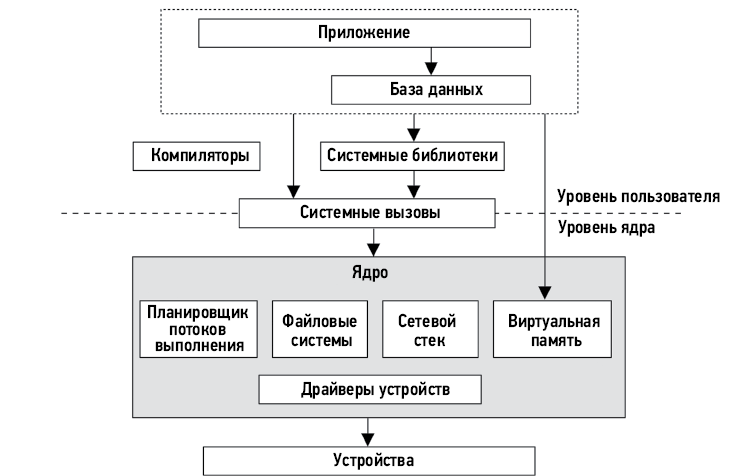

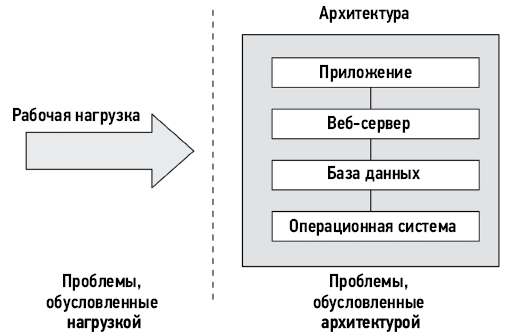

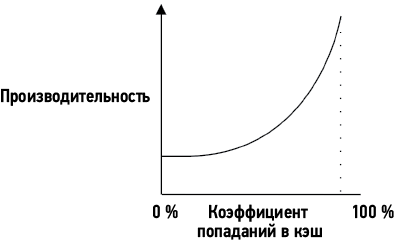

На рис. 1.1 показан обобщенный стек системного ПО на одном сервере, включая ядро операционной системы (ОС), базу данных и приложение. Иногда термин фуллстек используется для описания только прикладного окружения, включающего базы данных, приложения и веб-серверы. Но говоря о производительности системы, под словом фуллстек мы подразумеваем весь программный стек — от приложений до железа (оборудования), включая системные библиотеки, ядро и само оборудование. При оценке производительности системы рассматривается фуллстек.

Рис. 1.1. Обобщенный стек системного программного обеспечения

Компиляторы включены в обобщенный стек на рис. 1.1, потому что играют важную роль в производительности системы. Этот стек мы обсудим в главе 3 «Операционные системы» и подробно рассмотрим в последующих главах. В следующих разделах будут более подробно описаны особенности оценки производительности системы.

1.2. Роли

Производительность системы обеспечивается различными специалистами, в том числе системными администраторами, SRE-инженерами, разработчиками приложений, сетевыми инженерами, администраторами баз данных, веб-администраторами и др. Для многих из этих специалистов обеспечение производительности является лишь частью их работы, поэтому при оценке производительности они фокусируются только на своей сфере ответственности: группа сетевых администраторов проверяет производительность сетевого стека, группа администраторов баз данных проверяет базу данных, и т.д. Однако иногда для выяснения причин низкой производительности или факторов, способствующих этому, требуются совместные усилия нескольких команд.

В некоторых компаниях работают перформанс-инженеры, для которых обеспечение высокой производительности — основная деятельность. Они могут взаимодействовать с несколькими командами для проведения комплексного исследования среды, что нередко очень важно для решения сложных проблем с производительностью. Они также могут выступать в качестве центрального звена, осуществляющего поиск и разработку инструментов для анализа производительности и планирования ресурсов во всей среде.

Например, в Netflix есть команда по производительности облачных вычислений, в которую вхожу и я. Мы помогаем командам микросервисов и обеспечения надежности анализировать производительность и создаем инструменты оценки производительности для всех остальных.

Компании, нанимающие несколько перформанс-инженеров, могут позволить им специализироваться в одной или нескольких областях и обеспечивать более глубокую поддержку. Например, большая группа перформанс-инженеров может включать специалистов по производительности ядра, клиентских приложений, языка (например, Java), среды выполнения (например, JVM), по разработке инструментов для оценки производительности и т.д.

1.3. Действия

Анализ и увеличение производительности системы предполагают выполнение множества действий. Ниже приводится список таких действий, которые одновременно представляют этапы идеального жизненного цикла программного проекта — от идеи до разработки и развертывания в продакшене. В этой книге описаны методологии и инструменты, помогающие выполнять эти действия.

1. Определение целей и моделирование производительности будущего продукта.

2. Определение характеристик производительности прототипа программного и аппаратного обеспечения.

3. Анализ производительности разрабатываемых продуктов в тестовой среде.

4. Регрессионное тестирование новых версий продукта.

5. Бенчмаркинг производительности разных версий продуктов.

6. Проверка концепции в целевой промышленной среде.

7. Оптимизация производительности в промышленной среде.

8. Мониторинг ПО, действующего в промышленной среде.

9. Анализ производительности промышленных задач.

10. Ревью инцидентов, возникающих в промышленной среде.

11. Разработка инструментов для повышения эффективности анализа производительности в промышленной среде.

Шаги с 1-го по 5-й охватывают традиционный процесс разработки продукта, будь то продукт, продаваемый клиентам или используемый внутри компании. После разработки продукт вводится в эксплуатацию, иногда сначала проверяется пригодность использования продукта в целевой среде (клиента или внутри компании), а иногда сразу же производится развертывание и настройка. Если в целевой среде обнаружится проблема (шаги с 6-го по 9-й), это говорит только о том, что она не была обнаружена или исправлена на этапах разработки.

В идеале проектирование производительности должно начинаться до выбора какого-либо оборудования или создания программного обеспечения: первым шагом должны быть постановка целей и создание модели производительности. Однако часто продукты разрабатываются, минуя этот шаг, из-за чего работы по проектированию производительности откладываются на более позднее время, когда проблемы уже возникнут. С каждым следующим этапом процесса разработки становится все труднее устранять проблемы с производительностью, обусловленные ранее принятыми архитектурными решениями.

Облачные вычисления предлагают новые методы проверки концепции (шаг 6), которые побуждают пропускать более ранние шаги (с 1-го по 5-й). Один из таких методов — тестирование нового ПО на единственном экземпляре с небольшой рабочей нагрузкой: это называется канареечным тестированием. Другой метод превращает его в обычный шаг при развертывании: трафик постепенно перемещается в новый пул экземпляров, при этом старый пул остается в горячем резерве; этот метод известен как сине-зеленое развертывание8. Применение таких приемов защиты от сбоев в новом ПО позволяет проводить тестирование в продакшене без всякого предварительного анализа производительности и при необходимости быстро возвращаться к исходному состоянию. Но я рекомендую всегда, когда это возможно, выполнить также первые этапы, чтобы достичь максимальной производительности (даже при том, что иногда могут быть веские причины миновать их, например, быстрый выход на рынок).

Некоторые из перечисленных этапов охватываются термином планирование мощности (capacity planning). На этапе проектирования он подразумевает изучение объема ресурсов, необходимых разрабатываемому ПО, чтобы увидеть, насколько полно его архитектура может удовлетворить целевые потребности. После развертывания он подразумевает мониторинг использования ресурсов для прогнозирования проблем до их возникновения.

В анализ производительности в промышленной среде (шаг 9) могут также вовлекаться SRE-инженеры. Далее следует шаг по ревью инцидентов в промышленной среде (шаг 10), когда производится анализ произошедшего, обмен опытом отладки и поиск способов избежать аналогичных инцидентов в будущем. Эти ревью похожи на ретроспективы разработчиков (см. [Corry 20], где рассказывается, что такое ретроспективы и их антипаттерны).

Среды и мероприятия различаются для разных компаний и продуктов, и во многих случаях выполняются не все десять шагов. Ваша работа также может быть сосредоточена только на некоторых или только на одном из этих мероприятий.

1.4. Перспективы

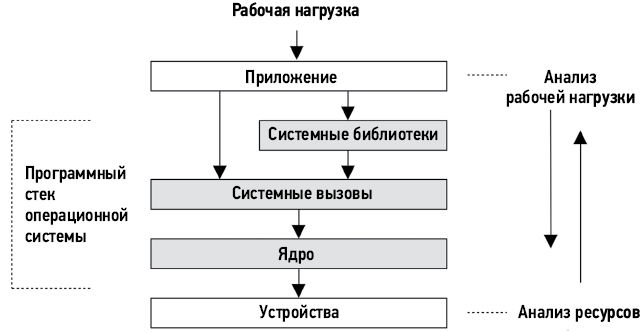

Помимо выполнения различных мероприятий, привлечение различных специалистов можно рассматривать как использование разных точек зрения — перспектив. На рис. 1.2 обозначены две точки зрения на анализ производительности: анализ рабочей нагрузки и анализ ресурсов — двух подходов к оценке программного стека.

Рис. 1.2. Анализ с двух перспектив

Перспектива анализа ресурсов обычно используется системными администраторами, отвечающими за системные ресурсы. Разработчики приложений, отвечающие за производительность под рабочей нагрузкой, обычно сосредоточиваются на перспективе анализа рабочей нагрузки. Каждая перспектива имеет свои сильные стороны, которые подробно обсуждаются в главе 2 «Методологии». При решении сложных вопросов полезно попытаться проанализировать ситуацию с обеих сторон.

1.5. Сложности оценки производительности

Проектирование производительности системы — сложная область по многим причинам, в том числе из-за субъективности, природной сложности, отсутствия какой-то единственной основной причины и наличия множества связанных проблем.

1.5.1. Субъективность

Технические дисциплины тяготеют к объективности, причем настолько, что занимающиеся ими люди видят мир в черно-белом цвете. Это может быть верно в отношении неполадок в софте, когда ошибка либо есть, либо ее нет и либо она исправлена, либо не исправлена. Такие ошибки часто проявляются в виде сообщений, которые легко интерпретировать и идентифицировать как сообщения об ошибках.

Производительность, напротив, часто бывает субъективной. В отношении проблем с производительностью часто неочевидно, имела ли место проблема изначально, и если да, то когда она была устранена. Один пользователь может считать производительность «плохой» и рассматривать ее как проблему, а другой может считать ее «хорошей».

Например, представьте, что вам поступила такая информация:

Среднее время отклика подсистемы дискового ввода/вывода составляет 1 мс.

Это «хорошо» или «плохо»? Время отклика, или задержка, является одним из лучших доступных показателей, но интерпретировать информацию о задержке сложно. Часто выбор между оценками «хорошая» или «плохая» зависит от ожиданий разработчиков приложений и конечных пользователей.

Субъективную оценку производительности можно сделать объективной, определив четкие цели, например целевое среднее время отклика или попадание определенного процента запросов в некоторый диапазон задержек. Другие способы борьбы с субъективностью будут представлены в главе 2 «Методологии», в том числе и анализ задержки.

1.5.2. Сложность

Помимо субъективности, сложность оценки производительности может быть связана со свойственной системам сложностью и отсутствием очевидной отправной точки для анализа. В облачных средах порой даже нет возможности узнать, на какой экземпляр обратить внимание в первую очередь. Иногда мы начинаем с выдвижения гипотезы, например, обвиняя сеть или базу данных, а аналитик производительности должен выяснить, является ли эта гипотеза верной.

Проблемы с производительностью также могут возникать из-за сложных взаимодействий между подсистемами, которые показывают хорошие характеристики при их анализе в изоляции друг от друга. Падение производительности может произойти из-за каскадного сбоя, когда один отказавший компонент вызывает проблемы с производительностью в других компонентах. Чтобы понять причину возникшей проблемы, необходимо распутать клубок взаимосвязей между компонентами и понять, какой вклад они вносят.

Сложность также может быть обусловлена наличием неожиданных взаимосвязей, когда устранение проблемы в одном месте может привести к появлению проблемы в другом месте системы, при этом общая производительность улучшится не так сильно, как ожидалось. Помимо сложности системы, проблемы с производительностью также могут быть вызваны сложным характером производственной нагрузки. Некоторые случаи могут просто не воспроизводиться в лабораторных условиях или возникать лишь периодически.

Решение сложных проблем производительности часто требует комплексного подхода. Возможно, потребуется исследовать всю систему — и ее внутренние элементы, и внешние взаимодействия. Для этого необходимо обладать широким спектром навыков, что может сделать проектирование производительности многообразным и интеллектуально сложным делом.

Для преодоления этих сложностей можно использовать разные методологии, как описано в главе 2. В главах 6–10 вы найдете описания конкретных методологий анализа конкретных системных ресурсов: процессоры, память, файловые системы, диски и сеть. (Комплексный анализ сложных систем, включая разливы нефти и крах финансовых систем, описан в [Dekker 18].)

В некоторых случаях проблема производительности может быть вызвана взаимодействием этих ресурсов.

1.5.3. Множественные причины

Некоторые проблемы с производительностью не имеют единственной первопричины и обусловлены множеством факторов. Представьте сценарий, когда одновременно происходят три вполне обычных события, которые в совокупности вызывают проблему с производительностью: каждое из этих событий — обычное и само по себе не является первопричиной.

Множественными могут быть не только причины, но и сами проблемы с производительностью.

1.5.4. Множественные проблемы с производительностью

В сложном программном обеспечении обычно бывает немало проблем с производительностью. Для примера попробуйте найти базу данных ошибок для вашей ОС или приложений и поищите по слову performance (производительность). Результаты могут удивить вас! Как правило, в таких базах данных даже для зрелого ПО, считающегося высокопроизводительным, есть множество известных, но пока не исправленных проблем с производительностью. Это создает еще одну трудность при анализе: настоящая задача не в том, чтобы найти проблему, а в том, чтобы определить, какая проблема или проблемы наиболее важны.

Для этого специалист по анализу производительности должен количественно оценить масштаб проблемы. Некоторые проблемы с производительностью могут быть не свойственны вашей рабочей нагрузке или проявляться в весьма незначительной степени. В идеале вы должны не только количественно оценить проблемы, но также оценить потенциальное ускорение, которое можно получить за счет устранения каждой из них. Эта информация может пригодиться, когда менеджеры будут искать оправдание расходам на инженерные или операционные ресурсы.

Один из показателей, хорошо подходящих для количественной оценки производительности, если он доступен, — это задержка.

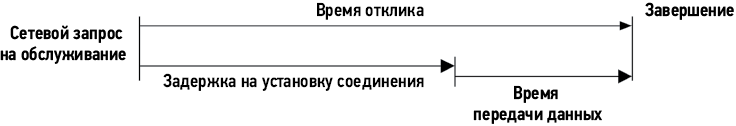

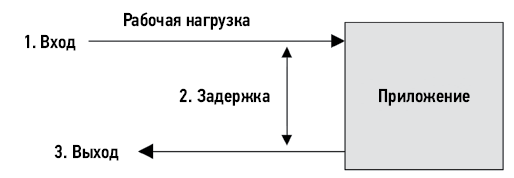

1.6. Задержка

Задержка характеризует время, затраченное на ожидание, и является важной метрикой производительности. В широком смысле под задержкой понимается время до завершения любой операции, такой как обработка запроса приложением или базой данных, операция файловой системы и т.д. Например, задержка может выражать время полной загрузки веб-страницы от щелчка на ссылке до появления полного изображения страницы на экране. Это важный показатель как для клиента, так и для владельца сайта: большая задержка может вызвать разочарование и желание у клиентов разместить заказ в другом месте.

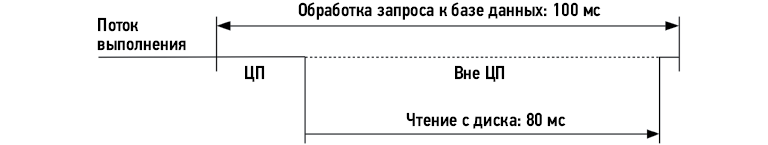

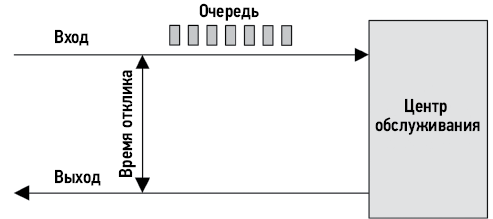

В роли метрики задержка позволяет оценить максимальное ускорение. Например, на рис. 1.3 изображена временна́я диаграмма обработки запроса к базе данных, на что уходит 100 мс (это время и является задержкой), из которых 80 мс тратится на ожидание завершения операции чтения с диска. В данном случае за счет исключения операций чтения с диска (например, путем кэширования) можно добиться уменьшения времени обработки со 100 мс до 20 мс (100–80), то есть добиться пятикратного (в 5 раз) улучшения производительности. Это оценочное ускорение, и вычисления также помогли количественно оценить масштаб проблемы производительности: чтение с диска в 5 раз замедляет обработку запросов.

Рис. 1.3. Пример задержки, вызванной дисковым вводом/выводом

Подобные вычисления невозможны при использовании других метрик. Например, количество операций ввода/вывода в секунду (IOPS) зависит от типа ввода/вывода и часто напрямую несопоставимо для разных ситуаций. Если какое-то изменение приведет к уменьшению IOPS на 80 %, то трудно предсказать, как это отразится на производительности. Операций в секунду может быть в 5 раз меньше, но что, если каждая из этих операций обрабатывает в 10 раз больше данных?

Значение задержки также может быть неоднозначным без уточняющих терминов. Например, задержка в сети может означать время, необходимое для установления соединения, но не время передачи данных; или общую продолжительность соединения, включая передачу данных (например, так обычно измеряется задержка DNS). По мере возможности в этой книге я буду использовать уточняющие термины: эти примеры лучше описать как задержку соединения и задержку обработки запроса. Терминология, связанная с задержкой, также приводится в начале каждой главы.

Задержка — полезная метрика, но она не всегда доступна. Некоторые системные области позволяют измерить только среднюю задержку; некоторые вообще не дают возможности измерения. С появлением новых инструментов наблюдения на основе BPF9 задержку теперь можно измерять практически в любых точках и получить данные, описывающие полное распределение задержки.

1.7. Наблюдаемость

Под наблюдаемостью подразумевается исследование системы через наблюдение и инструменты, предназначенные для этого. Сюда входят инструменты, использующие счетчики, профилирование и трассировку, но не входят инструменты тестирования производительности, которые изменяют состояние системы, выполняя эксперименты с рабочей нагрузкой. В промышленных средах желательно сначала попробовать применить инструменты наблюдения, где это возможно, потому что инструменты для экспериментов могут препятствовать обработке промышленных рабочих нагрузок из-за конкуренции за ресурсы. В тестовых средах, которые большую часть времени простаивают, можно сразу начать с инструментов тестирования производительности для определения быстродействия оборудования.

В этом разделе я расскажу о счетчиках, метриках, профилировании и трассировке. Более подробно о наблюдаемости речь пойдет в главе 4, где рассмотрены общесистемная и индивидуальная наблюдаемость, инструменты наблюдения Linux и их внутреннее устройство. Кроме того, в главах 5–11 есть разделы, посвященные наблюдаемости, например, раздел 6.6 описывает инструменты наблюдения за процессором.

1.7.1. Счетчики, статистики и метрики

Приложения и ядро обычно предоставляют данные c информацией о своем состоянии и активности: счетчики операций, счетчики байтов, измеренные задержки, использованный объем ресурсов и частоту ошибок. Обычно эти данные доступны в виде целочисленных переменных, называемых счетчиками; они жестко «вшиты» в программное обеспечение, часть из них являются кумулятивными и постоянно увеличиваются. Эти кумулятивные счетчики можно читать в разное время инструментами оценки производительности для вычисления таких статистик, как скорость изменения во времени, среднее значение, процентили и т.д.

Например, утилита vmstat(8) выводит общесистемную статистику по виртуальной памяти и другие данные на основе счетчиков ядра, доступных в файловой системе /proc. Вот пример вывода vmstat(8) на производственном сервере с 48 процессорами:

$ vmstat 1 5

procs ---------memory---------- ---swap-- -----io---- -system-- ------cpu-----

r b swpd free buff cache si so bi bo in cs us sy id wa st

19 0 0 6531592 42656 1672040 0 0 1 7 21 33 51 4 46 0 0

26 0 0 6533412 42656 1672064 0 0 0 0 81262 188942 54 4 43 0 0

62 0 0 6533856 42656 1672088 0 0 0 8 80865 180514 53 4 43 0 0

34 0 0 6532972 42656 1672088 0 0 0 0 81250 180651 53 4 43 0 0

31 0 0 6534876 42656 1672088 0 0 0 0 74389 168210 46 3 51 0 0

Судя по этому примеру, доля занятости процессора в системе составляет около 57 % (столбцы cpu us + sy). Более подробно значение столбцов объясняется в главах 6 и 7.

Метрика — это статистика, выбранная для оценки или мониторинга цели. Большинство компаний используют агенты мониторинга для записи выбранных статистик (метрик) через регулярные промежутки времени и построения графиков их изменения в графическом интерфейсе, чтобы видеть, как они меняются с течением времени. Программное обеспечение для мониторинга также может поддерживать создание специальных предупреждений на основе этих метрик, например отправку электронных писем для уведомления персонала об обнаружении проблем.

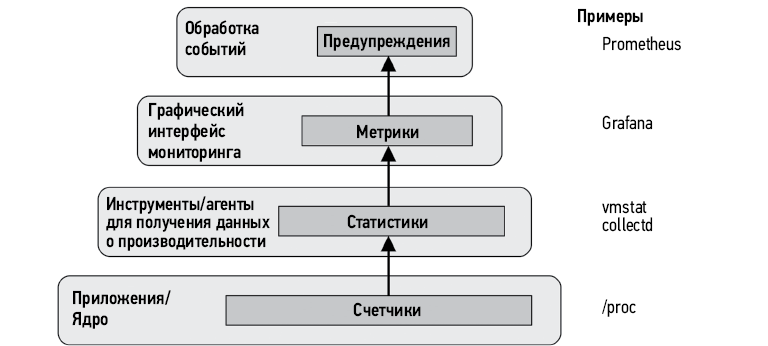

Эта иерархия от счетчиков до предупреждений изображена на рис. 1.4, который поможет вам понять эти термины, но их использование в отрасли не является жестко фиксированным. Термины счетчики, статистики и метрики часто используются как синонимы. Кроме того, оповещения могут генерироваться на любом уровне, а не только специальной системой оповещения.

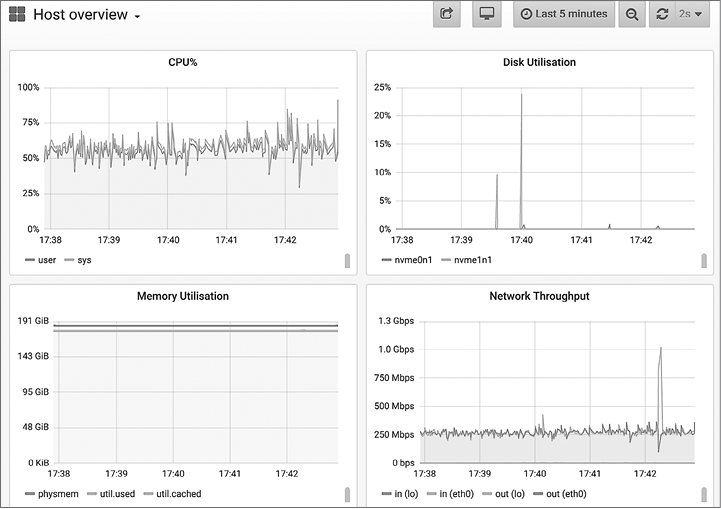

В качестве примера графического представления метрик на рис. 1.5 показан скриншот инструмента на основе Grafana, который наблюдает за тем же сервером, на котором был получен предыдущий вывод vmstat(8).

Эти линейные графики удобно использовать для планирования мощности — они помогают предсказать, когда наступит момент исчерпания ресурсов.

Ваша интерпретация статистик производительности улучшится, если вы поймете, как они вычисляются. Статистики, включая средние значения, распределения, моды и выбросы, более подробно описываются в главе 2 «Методологии», в разделе 2.8 «Статистики».

Иногда для решения проблемы с производительностью достаточно получить временны́е ряды с метриками. Время, когда проявилась проблема, может коррелировать с известным изменением в ПО или конфигурации, которое можно отменить. Иногда метрики лишь подсказывают направление, сообщая о проблеме с процессором или диском, но без объяснения причин. В таких случаях, чтобы копнуть глубже и отыскать причину, необходимо использовать инструменты профилирования.

Рис. 1.4. Терминология, связанная с оценкой производительности

Рис. 1.5. Графический интерфейс с метриками (Grafana)

1.7.2. Профилирование

В контексте производительности систем термин профилирование обычно означает использование инструментов для выборки подмножества измерений и создания на их основе приблизительной картины, характеризующей цель. Часто целью профилирования является доля занятости процессора. Обычно для этого используется метод профилирования, основанный на выборке путей в коде, выполняющемся на процессоре, с заданным интервалом времени.

Один из эффективных способов визуализации результатов профилирования процессора — флейм-графики (или графики пламени — flame graphs). Флейм-графики помогают добиться большего выигрыша в производительности, чем любой другой инструмент, после метрик. Они позволяют выявить не только проблемы с занятостью процессора, но и другие типы проблем, обнаруживаемые по характерным особенностям использования процессора. Проблемы, связанные с конфликтом блокировок, например, можно обнаружить по большим затратам процессорного времени в циклах ожидания блокировок; проблемы с памятью легко обнаруживаются по чрезмерным затратам процессорного времени в функциях распределения памяти (malloc()) и в коде, вызывающем эти функции; проблемы, связанные с ошибками в настройках сети, можно обнаружить по затратам процессорного времени в медленных или устаревших путях в коде; и т.д.

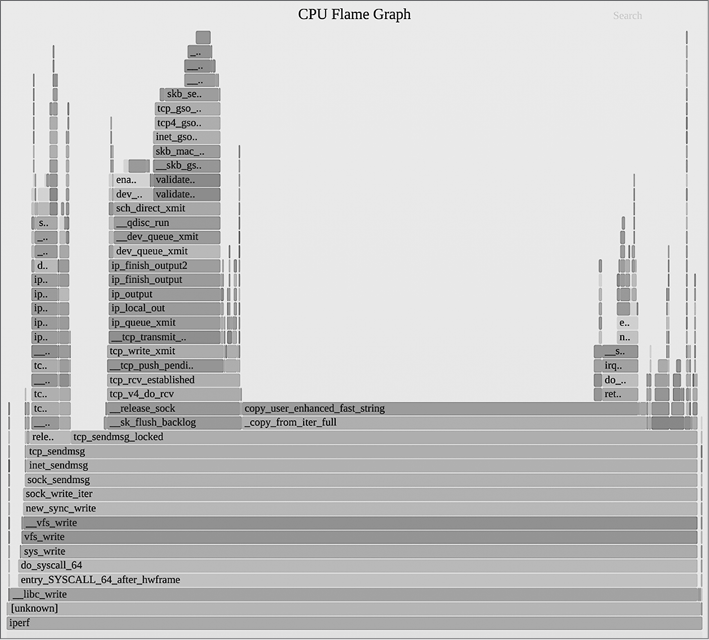

На рис. 1.6 приведен пример флейм-графика, показывающего процессорное время, потраченное инструментом тестирования сети iperf(1).

Рис. 1.6. Флейм-график расходования процессорного времени

На этом флейм-графике видно, насколько больше процессорного времени тратится на копирование байтов (путь в коде, заканчивающийся функцией copy_user_enhanced_fast_string()) по сравнению с передачей TCP-пакетов (второй большой пик слева, включающий функцию tcp_write_xmit()). Ширина пиков (или пирамид, как их еще называют) пропорциональна потраченному процессорному времени, а вдоль вертикальной оси откладывается путь в коде.

Подробнее приемы профилирования обсуждаются в главах 4, 5 и 6, а об использовании флейм-графиков рассказывается в главе 6 «Процессор», в разделе 6.7.3 «Флейм-графики».

1.7.3. Трассировка

Трассировка — это запись событий, когда данные о событиях фиксируются и сохраняются для последующего анализа или используются на лету для обобщения и выполнения других действий. Есть специальные инструменты трассировки для системных вызовов (например, strace(1) в Linux) и сетевых пакетов (например, tcpdump(8) в Linux), а также инструменты трассировки общего назначения, способные анализировать все программные и аппаратные события (например, Ftrace, BCC и bpftrace в Linux). Эти всевидящие трассировщики используют различные источники событий, в частности точки статической и динамической инструментации, а также механизм BPF, поддерживающий возможность программного управления.

Точки статической инструментации

Под точками статической инструментации подразумеваются жестко закодированные точки в ПО. В ядре Linux сотни таких точек, позволяющих выполнять трассировку дискового ввода/вывода, событий планировщика, системных вызовов и многого другого. Технология статической инструментации ядра Linux называется tracepoints (точки трассировки). Есть технология статической инструментации ПО в пространстве пользователя, которая называется статически определяемой трассировкой на уровне пользователя (User-level Statically Defined Tracing, USDT). Точки USDT используются во многих библиотеках (например, libc) для инструментации библиотечных вызовов и в приложениях для инструментации функций обработки запросов.

Примером утилиты, использующей статическую инструментацию, может служить execsnoop(8), которая выводит информацию о процессах, запущенных во время трассировки, получаемую путем инструментации точки трассировки в системном вызове execve(2). Ниже показано, как execsnoop(8) трассирует вход по SSH:

# execsnoop

PCOMM PID PPID RET ARGS

ssh 30656 20063 0 /usr/bin/ssh 0

sshd 30657 1401 0 /usr/sbin/sshd -D -R

sh 30660 30657 0

env 30661 30660 0 /usr/bin/env -i PATH=/usr/local/sbin:/usr/local...

run-parts 30661 30660 0 /bin/run-parts --lsbsysinit /etc/update-motd.d

00-header 30662 30661 0 /etc/update-motd.d/00-header

uname 30663 30662 0 /bin/uname -o

uname 30664 30662 0 /bin/uname -r

uname 30665 30662 0 /bin/uname -m

10-help-text 30666 30661 0 /etc/update-motd.d/10-help-text

50-motd-news 30667 30661 0 /etc/update-motd.d/50-motd-news

cat 30668 30667 0 /bin/cat /var/cache/motd-news

cut 30671 30667 0 /usr/bin/cut -c -80

tr 30670 30667 0 /usr/bin/tr -d \000-\011\013\014\016-\037

head 30669 30667 0 /usr/bin/head -n 10

80-esm 30672 30661 0 /etc/update-motd.d/80-esm

lsb_release 30673 30672 0 /usr/bin/lsb_release -cs

[...]

Этот прием особенно удобен для трассировки короткоживущих процессов, которые могут остаться незамеченными другими инструментами наблюдения, такими как top(1). Эти короткоживущие процессы могут быть источником проблем с производительностью.

Дополнительную информацию о точках трассировки и зондах USDT вы найдете в главе 4.

Динамическая инструментация

Технология динамической инструментации создает точки трассировки уже после запуска ПО путем подмены инструкций в памяти процесса вызовами процедур трассировки. Примерно так отладчики вставляют точки останова в любые функции в запущенном ПО. Разница лишь в том, что когда при отладке поток выполнения достигает точки останова, управление передается интерактивному отладчику, а при динамической инструментации вызывается процедура трассировки, по окончании которой целевое ПО продолжает работу как ни в чем не бывало. Динамическая инструментация позволяет собирать необходимую статистику производительности из любого выполняющегося ПО. Проблемы, которые раньше было невозможно или очень сложно решить из-за недостаточной наблюдаемости, теперь можно исправить.

Динамическая инструментация настолько отличается от традиционного наблюдения и мониторинга, что поначалу трудно понять ее роль. Возьмем для примера ядро операционной системы: анализ внутреннего устройства ядра часто похож на блуждание в темной комнате со свечами (системными счетчиками), установленными там, где разработчики ядра посчитали необходимым. Динамическую инструментацию я бы сравнил с фонариком, луч которого можно направить куда угодно.

Первые методы динамической инструментации были разработаны в 1990-х годах [Hollingsworth 94] вместе с инструментами, которые их используют. Эти инструменты называют динамическими трассировщиками (например, kerninst [Tamches 99]). Поддержка динамической инструментации для ядра Linux была разработана в 2000 году [Kleen 08] и начала внедряться в 2004 году (kprobes). Но эти технологии были малоизвестны и сложны в использовании. Ситуация изменилась, когда в 2005 году Sun Microsystems выпустила свою версию DTrace — простую в использовании и безопасную для применения в производственной среде. Я разработал множество инструментов на основе DTrace, которые доказали свою важность для оценки производительности системы, получили широкое распространение и принесли широкую известность DTrace и динамической инструментации.

BPF

Механизм BPF, название которого первоначально произошло от Berkeley Packet Filter, поддерживает новейшие инструменты динамической трассировки для Linux. BPF создавался как миниатюрная виртуальная машина в ядре для ускорения выполнения выражений tcpdump(8). Но в 2013 году был расширен (поэтому иногда его называют eBPF10) и превратился в универсальную среду выполнения в ядре, обеспечивающую безопасный и быстрый доступ к ресурсам. Среди многочисленных новых применений обновленного механизма BPF — инструменты трассировки, для которых он обеспечивает поддержку программирования операций с применением коллекции компиляторов BPF (BPF Compiler Collection, BCC), и внешний интерфейс bpftrace. Например, инструмент execsnoop(8), показанный выше, является инструментом BCC11.

Подробнее о BPF рассказывается в главе 3, а глава 15 знакомит с интерфейсами трассировки BPF: BCC и bpftrace. В других главах, в разделах о наблюдаемости, будут представлены многие инструменты трассировки на основе BPF; например, инструменты трассировки процессора описываются в главе 6 «Процессор» в разделе 6.6 «Инструменты наблюдения». Также ранее я опубликовал книги по инструментам трассировки (для DTrace [Gregg 11a] и BPF [Gregg 19]).

Оба инструмента, perf(1) и Ftrace, тоже являются трассировщиками и обладают возможностями, аналогичными интерфейсам BPF. Подробнее о perf(1) и Ftrace рассказывается в главах 13 и 14.

1.8. Эксперименты

Помимо инструментов наблюдения, также есть инструменты для экспериментов, большинство из которых применяется для бенчмаркинга. Они позволяют ставить эксперименты, применяя искусственную рабочую нагрузку к системе и измеряя ее производительность. Такие эксперименты следует проводить с осторожностью, потому что они могут ухудшать производительность тестируемых систем.

Есть инструменты макробенчмарикинга, которые имитируют реальную рабочую нагрузку, например действия клиентов, посылающих запросы приложениям, а есть инструменты микробенчмаркинга, которые тестируют конкретный компонент системы, например процессоры, диски или сети. В качестве аналогии: определение времени, необходимого для преодоления круга на трассе Laguna Seca Raceway, можно считать макробенчмаркингом, а определение времени разгона от 0 до 100 км/ч можно считать микробенчмаркингом. Оба типа тестов важны, но микробенчмарки обычно проще в разработке, отладке, использовании и понимании, и они более стабильны.

Следующий пример показывает использование iperf(1) на простаивающем сервере для микробенчмаркинга пропускной способности канала TCP с удаленным неактивным сервером. Этот бенчмарк выполнялся в течение 10 с (-t 10) и выводит средние значения в секунду (-i 1):

# iperf -c 100.65.33.90 -i 1 -t 10

------------------------------------------------------------

Client connecting to 100.65.33.90, TCP port 5001

TCP window size: 12.0 MByte (default)

------------------------------------------------------------

[ 3] local 100.65.170.28 port 39570 connected with 100.65.33.90 port 5001

[ ID] Interval Transfer Bandwidth

[ 3] 0.0- 1.0 sec 582 MBytes 4.88 Gbits/sec

[ 3] 1.0- 2.0 sec 568 MBytes 4.77 Gbits/sec

[ 3] 2.0- 3.0 sec 574 MBytes 4.82 Gbits/sec

[ 3] 3.0- 4.0 sec 571 MBytes 4.79 Gbits/sec

[ 3] 4.0- 5.0 sec 571 MBytes 4.79 Gbits/sec

[ 3] 5.0- 6.0 sec 432 MBytes 3.63 Gbits/sec

[ 3] 6.0- 7.0 sec 383 MBytes 3.21 Gbits/sec

[ 3] 7.0- 8.0 sec 388 MBytes 3.26 Gbits/sec

[ 3] 8.0- 9.0 sec 390 MBytes 3.28 Gbits/sec

[ 3] 9.0-10.0 sec 383 MBytes 3.22 Gbits/sec

[ 3] 0.0-10.0 sec 4.73 GBytes 4.06 Gbits/sec

Как показывают результаты эксперимента, пропускная способность12 в первые 5 с находилась на уровне около 4,8 Гбит/с, а затем упала до примерно 3,2 Гбит/с. Этот интересный результат демонстрирует бимодальную пропускную способность. Чтобы увеличить производительность, можно сосредоточиться на моде 3,2 Гбит/с и поискать другие метрики, объясняющие ее.

Рассмотрим недостатки отладки подобной проблемы производительности на рабочем сервере с использованием только инструментов наблюдения. Пропускная способность сети может меняться с течением времени из-за естественной разницы в рабочей нагрузке клиента, и подобное бимодальное поведение сети может оставаться незамеченным. Используя инструмент iperf(1), генерирующий фиксированную рабочую нагрузку, можно избавиться от влияния изменчивости поведения клиентов и обнаружить отклонения, вызванные другими факторами (например, наличием ограничений во внешней сети, использованием буферов и т.д.).

Как я рекомендовал выше, в производственных системах следует сначала попробовать применить инструменты наблюдения. Но их так много, что с ними можно работать часами, тогда как инструмент для экспериментов позволит быстрее прийти к результатам. Много лет назад старший перформанс-инженер Рох Бурбоннис (Roch Bourbonnais) рассказал мне о такой аналогии: у вас есть две руки, наблюдение и эксперименты. Использование инструментов только одного типа похоже на попытку решить проблему одной рукой.

Главы 6–10 включают разделы об инструментах для экспериментирования. Например, инструменты для экспериментирования с процессором описаны в главе 6 «Процессор» в разделе 6.8 «Эксперименты».

1.9. Облачные вычисления

Облачные вычисления как способ развертывания вычислительных ресурсов по запросу позволяют быстро масштабировать приложения, развертывая их во все большем количестве небольших виртуальных систем, называемых экземплярами (instances). Этот подход избавляет от необходимости тщательно планировать емкость, потому что в кратчайшие сроки можно добавить дополнительные ресурсы из облака. В некоторых случаях это также увеличило потребность в анализе производительности, потому что использование меньшего количества ресурсов может означать меньшее количество систем. Поскольку за использование облачных ресурсов обычно взимается поминутная или часовая оплата, выигрыш в производительности, способствующий использованию меньшего количества систем, дает прямую экономию средств. Сравните этот сценарий с услугами корпоративного вычислительного центра, с которым вы можете быть связаны фиксированным договором на поддержку в течение многих лет без возможности экономии, пока срок действия договора не истечет.

Облачные вычисления и виртуализация принесли новые трудности, включая управление влиянием других подписчиков на производительность (иногда это называют изоляцией производительности) и возможность мониторинга физической системы со стороны каждого подписчика. Например, в отсутствие должного управления системой производительность дискового ввода/вывода может упасть из-за конфликта с соседом. В некоторых средах информация о фактической нагрузке на физические диски может быть недоступна подписчикам, что затрудняет выявление таких проблем.

Более подробно эти вопросы рассматриваются в главе 11 «Облачные вычисления».

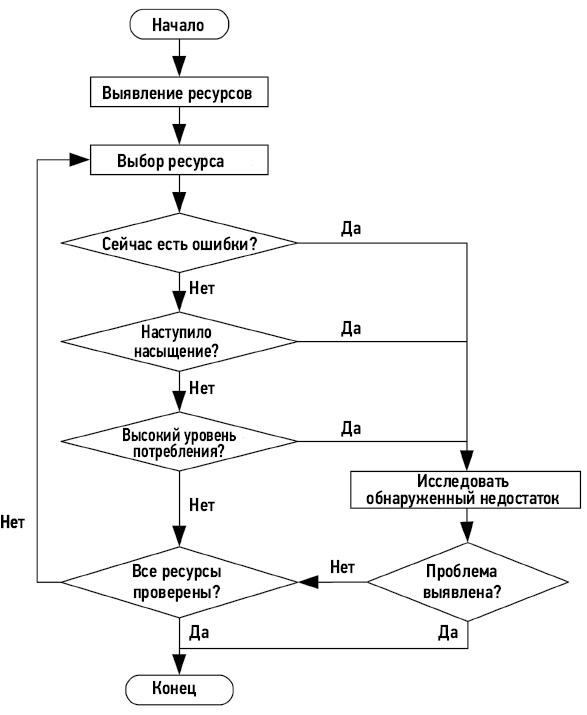

1.10. Методологии

Методология — это способ задокументировать рекомендуемые шаги для решения различных задач по оценке производительности системы. Без методологии исследование производительности может превратиться в рыбалку, когда рыбак пробует разные наживки в надежде на удачу. Это неэффективный и потенциально долгий путь с риском упустить из виду важные области. В главе 2 «Методологии» я привожу перечень методологий для оценки производительности систем. В следующем подразделе я покажу первое, что использую для решения любой проблемы с производительностью: чек-лист инструментов.

1.10.1. Анализ производительности Linux за 60 секунд

Это чек-лист инструментов анализа производительности для Linux, который можно выполнить за 60 секунд в самом начале исследования проблемы производительности. Здесь перечислены традиционные инструменты, доступные в большинстве дистрибутивов Linux [Gregg 15a]. В табл. 1.1 показаны конкретные команды, которые следует выполнить, а также разделы в этой книге, где соответствующие команды рассматриваются более подробно.

Таблица 1.1. Чек-лист для анализа производительности Linux за 60 секунд

| № |

Инструмент |

Проверяет |

Раздел |

| 1 |

uptime |

Средние значения нагрузки, чтобы определить, увеличивается или уменьшается нагрузка (можно сравнить средние значения за 1, 5 и 15 минут) |

6.6.1 |

| 2 |

dmesg -T | tail |

Ошибки в ядре, включая события OOM (нехватки памяти) |

7.5.11 |

| 3 |

vmstat -SM 1 |

Общесистемные статистики: длина очереди на выполнение, подкачка (swapping), общая доля занятости процессора |

7.5.1 |

| 4 |

mpstat -P ALL 1 |

Баланс нагрузки по процессорам: увеличенная нагрузка на один из процессоров может указывать на плохое масштабирование потоков выполнения |

6.6.3 |

| 5 |

pidstat 1 |

Потребление процессора каждым процессом: позволяет выявить непредвиденных потребителей процессорного времени и определить, сколько процессорного времени потрачено каждым процессом в пространстве ядра и в пространстве пользователя |

6.6.7 |

| 6 |

iostat -sxz 1 |

Статистики дискового ввода/вывода: количество операций ввода/вывода в секунду (IOPS) и пропускная способность, среднее время ожидания, процент занятости |

9.6.1 |

| 7 |

free –m |

Потребление памяти, включая кэши файловой системы |

8.6.2 |

| 8 |

sar -n DEV 1 |

Статистики сетевого устройства ввода/вывода: количество пакетов и пропускная способность |

10.6.6 |

| 9 |

sar -n TCP,ETCP |

Статистики TCP: частота приема соединений, частота повторных передач |

10.6.6 |

| 10 |

top |

Общий обзор |

6.6.6 |

Этот чек-лист также можно использовать в графическом интерфейсе мониторинга, если в нем доступны те же метрики13.

Глава 2 «Методологии» и следующие за ней содержат описание множества методологий анализа производительности, включая метод USE, определение характеристик рабочей нагрузки, анализ задержки и многие другие.

1.11. Практические примеры

Если вы новичок в вопросах оценки производительности систем, то практические примеры, показывающие, когда и почему выполняются различные действия, помогут вам провести аналогию с вашим текущим окружением. В этом разделе представлены два гипотетических примера. Первый показывает проблему производительности, связанную с дисковым вводом/выводом, а второй — тестирование производительности после изменения ПО.

Примеры описывают действия, о которых подробно рассказывается в других главах этой книги. Основная цель этих примеров — показать не правильный или единственный способ, а скорее один из способов, которым можно выполнить эти действия.

1.11.1. Медленные диски

Сумит — системный администратор в компании среднего размера. Группа обслуживания базы данных добавила тикет с жалобой на «медленные диски» на одном из серверов баз данных.

Первая задача Сумита — узнать как можно больше о проблеме, собрать необходимую информацию и сформулировать проблему. В тикете утверждается, что диски работают медленно, но не объясняется, действительно ли это является причиной проблемы в базе данных. В ответ Сумит задает следующие вопросы:

• Наблюдаются ли проблемы с производительностью базы данных сейчас? Как она измеряется?

• Как давно существует эта проблема?

• Изменилось ли что-нибудь в базе данных за последнее время?

• Почему подозрение пало на диски?

В ответ команда базы данных пишет: «В нашем отделе ведется журнал, в котором фиксируются запросы, продолжительность обработки которых превышает 1000 мс. Обычно такие запросы встречаются редко, но за последнюю неделю их число выросло до нескольких десятков в час. Анализ с применением AcmeMon показал большую загруженность дисков».

Этот ответ подтверждает наличие проблемы с базой данных, но также показывает, что гипотеза о том, что причиной является низкая производительность диска, скорее всего, является предположением. Сумит решает проверить диски, а также другие ресурсы на тот случай, если гипотеза окажется неверной.

AcmeMon — это базовая система мониторинга серверов компании, предоставляющая исторические графики изменения стандартных метрик операционной системы, которые можно получить с помощью mpstat(1), iostat(1) и других системных утилит. Сумит входит в AcmeMon, чтобы выполнить задуманные проверки.

На первом шаге Сумит применяет методологию USE (описывается в главе 2 «Методологии» в разделе 2.5.9), чтобы быстро проверить наличие узких мест в ресурсах. Как сообщила группа обслуживания базы данных, доля загруженности дисков достигла высокого уровня, около 80 %, тогда как потребление других ресурсов (процессор, сеть) намного ниже. По историческим данным выяснилось, что загруженность дисков неуклонно росла в течение последней недели, в то время как потребление процессора оставалось постоянным. Система AcmeMon не предоставляет статистики, характеризующие насыщенность или частоту ошибок для дисков, поэтому для применения методологии USE Сумит должен выполнить некоторые команды на самом сервере.

Он проверил счетчики ошибок дискового ввода/вывода в /sys — они оказались равны нулю. Запустил iostat(1), задав интервал равным одной секунде, и понаблюдал за изменением метрик потребления и насыщенности с течением времени. Система AcmeMon сообщала об уровне загруженности 80 %, но проводила измерения с интервалом в одну минуту. Используя интервал измерений в одну секунду, Сумит увидел, что загруженность диска колеблется, часто достигая 100 % и вызывая увеличение уровня насыщенности и задержки дискового ввода/вывода.

Чтобы еще раз убедиться, что загруженность диска является причиной блокировки базы данных и возрастает синхронно с запросами к ней, он решил использовать инструмент трассировки BCC/BPF под названием offcputime(8) и с его помощью захватывать трассировки стека всякий раз, когда база приостанавливается ядром, а также определять продолжительность приостановки. Трассировки стека показали, что база данных часто блокируется на время чтения файловой системы в процессе обработки запроса. Для Сумита этого было достаточно.

Следующий вопрос — почему. Статистики производительности диска соответствуют высокой нагрузке. Сумит решил выяснить характеристики рабочей нагрузки, измерив с помощью iostat(1) частоту операций ввода/вывода, пропускную способность, среднюю задержку дискового ввода/вывода и соотношение операций чтения/записи. Для получения дополнительной информации Сумит мог бы использовать трассировку дискового ввода/вывода, однако ему достаточно информации, указывающей, что имеет место высокая нагрузка на диск, а не проблема с производительностью дисков.

Сумит добавляет дополнительные детали в тикет, указав, что было проверено, и включив скриншоты команд, использовавшихся для анализа работы дисков. На данный момент он пришел к выводу, что диски работают под высокой нагрузкой, из-за чего увеличивается задержка ввода/вывода и медленно обрабатываются запросы. Но судя по имеющимся данным, диски вполне справляются с нагрузкой, и он задает вопрос: есть ли простое объяснение случившемуся; увеличилась ли нагрузка на базу данных?

Команда обслуживания БД ответила, что простого объяснения нет и количество запросов (о которых не сообщает AcmeMon) остается постоянным. Похоже, это согласуется с более ранним выводом о неизменности нагрузки на процессор.

Сумит размышляет о том, какие еще причины могут вызвать увеличение нагрузки на дисковый ввод/вывод без заметного увеличения потребления процессора, и консультируется со своими коллегами. Один из них выдвигает предположение о сильной фрагментированности файловой системы, что вполне ожидаемо, когда заполненность файловой система приближается к 100 %. Но, как выяснил Сумит, файловая система заполнена всего на 30 %.

Сумит знает, как провести более детальный анализ14, чтобы выяснить точные причины, но на это требуется много времени. Основываясь на своем знании стека ввода/вывода в ядре, он пытается придумать другие простые объяснения, которые можно быстро проверить. Он помнит, что часто дисковые операции обусловлены промахами кэша файловой системы (кэша страниц).

Сумит проверяет коэффициент попаданий в кэш файловой системы с помощью cachestat(8)15 и обнаруживает, что в данный момент он составляет 91 %. Выглядит неплохо (и даже очень хорошо), но у него нет исторических данных для сравнения. Тогда он заходит на другие серверы баз данных, обслуживающие аналогичные рабочие нагрузки, и обнаруживает, что в них коэффициент попадания в кэш превышает 98 %. Он также обнаруживает, что размер кэша файловой системы на других серверах намного больше.

Обратив внимание на размер кэша файловой системы и потребление памяти сервера, он замечает, что было упущено из виду: в разрабатываемом проекте имеется прототип приложения, потребляющий все больше памяти, хотя пока работает вхолостую. В результате для кэша файловой системы остается меньше свободной памяти, из-за чего снижается частота попаданий в кэш и увеличивается количество дисковых операций чтения с диска.

Сумит связался с командой разработчиков приложения и попросил их остановить приложение и переместить его на другой сервер, сославшись на проблему с базой данных. После того как они выполнили его просьбу, Сумит увидел в AcmeMon, как по мере восстановления кэша файловой системы до исходного объема нагрузка на диск стала постепенно снижаться. Количество медленно обрабатываемых запросов упало до нуля, и он закрыл тикет как разрешенный.

1.11.2. Изменение в программном обеспечении

Памела — перформанс-инженер в небольшой компании, она занимается всем, что так или иначе связано с производительностью. Разработчики приложений реализовали новую возможность, но не уверены, что ее внедрение не ухудшит производительность. Памела решает провести регрессионное тестирование новой версии приложения перед внедрением в продакшен.

Для тестирования Памела выбирает простаивающий сервер, и теперь ей нужен имитатор рабочей нагрузки клиента. В недавнем прошлом группа разработчиков приложений написала такой имитатор, но у него есть различные ограничения и известные ошибки. Памела решает попробовать его, но прежде хочет убедиться, что он способен создавать рабочую нагрузку, адекватную текущей.

Она настраивает сервер в соответствии с текущей конфигурацией развертывания и запускает имитатор в другой системе для создания рабочей нагрузки на сервер. Нагрузку, имитирующую действия клиентов, можно оценить, изучив журнал доступа, и в компании уже есть подходящий для этого инструмент. Она запускает этот инструмент, передает ему журнал с рабочего сервера с данными за разные периоды в течение суток и сравнивает рабочие нагрузки. Как оказалось, имитатор создает среднюю рабочую нагрузку без всяких отклонений. Она отмечает это и продолжает анализ.

Памела знает несколько подходов, которые можно применить на этом этапе. Она выбирает самый простой: увеличивать нагрузку до достижения предела (иногда этот подход называют стресс-тестированием). Имитатор клиента можно настроить на отправку определенного количества клиентских запросов в секунду со значением по умолчанию 1000. Она решает начать со 100 запросов в секунду и постепенно увеличивать нагрузку с шагом 100, пока не будет достигнут предел, при этом на каждом уровне нагрузки тестирование продолжается в течение одной минуты. Она пишет сценарий на языке командной оболочки, который собирает результаты в файл для анализа другими инструментами.

При действующей нагрузке она проводит активный анализ производительности, чтобы выявить ограничивающие факторы. Ресурсы сервера кажутся свободными, а потоки выполнения по большей части бездействующими. Как показал имитатор, пропускная способность составила примерно 700 запросов в секунду.

После этого она запускает новую версию приложения и повторяет тесты. Достигается тот же уровень 700 запросов в секунду, и никаких ограничивающих факторов не выявляется.