автордың кітабын онлайн тегін оқу Python: Искусственный интеллект, большие данные и облачные вычисления

Переводчики А. Логунов, Е. Матвеев

Технические редакторы Д. Абрамова, А. Шляго (Шантурова)

Литературные редакторы М. Петруненко, М. Рогожин

Художники Л. Егорова, В. Мостипан, А. Шляго (Шантурова)

Корректоры Н. Викторова, М. Молчанова (Котова)

Верстка Л. Егорова

Пол Дейтел, Харви Дейтел

Python: Искусственный интеллект, большие данные и облачные вычисления. — СПб.: Питер, 2021.

ISBN 978-5-4461-1432-0

© ООО Издательство "Питер", 2021

Все права защищены. Никакая часть данной книги не может быть воспроизведена в какой бы то ни было форме без письменного разрешения владельцев авторских прав.

В память о Марвине Мински, отце-основателе искусственного интеллекта.

Мне выпала честь учиться у вас на двух учебных курсах по искусственному интеллекту в Массачусетском технологическом институте.

Вы вдохновляли ваших студентов мыслить, выходя за рамки традиционных представлений.

Харви Дейтел

Предисловие

«Там золото в этих холмах!»1

Перед вами книга «Python: Искусственный интеллект, большие данные и облачные вычисления». В ней вы займетесь практическим освоением самых интересных, самых революционных вычислительных технологий, а также программированием на Python — одном из самых популярных языков программирования в мире, лидирующем по темпам развития.

Python обычно сразу приходится по нраву разработчикам. Они ценят Python за выразительность, удобочитаемость, компактность и интерактивную природу. Разработчикам нравится мир разработки с открытым кодом, который порождает стремительно растущую базу программного обеспечения для невероятно широкого спектра прикладных областей.

Уже много десятилетий в мире действуют определенные тенденции. Компьютерное оборудование становится быстрее, дешевле и компактнее. Скорость доступа к интернету растет и дешевеет. Качественное программное обеспечение становится более массовым и практически бесплатным (или почти бесплатным) благодаря движению «открытого кода». Вскоре «интернет вещей» объединит десятки миллиардов устройств любых видов, которые только можно представить. Они порождают колоссальные количества данных на быстро растущих скоростях и объемах.

В современных вычислениях большинство последних новшеств связано с данными — data science, аналитика данных, большие данные, реляционные базы данных (SQL), базы данных NoSQL и NewSQL… Все эти темы будут рассматриваться в книге в сочетании с инновационным подходом к программированию на Python.

Спрос на квалификацию в области data science

В 2011 году Глобальный институт McKinsey опубликовал отчет «Большие данные: новый рубеж для инноваций, конкуренции и производительности». В отчете было сказано: «Только Соединенные Штаты сталкиваются с нехваткой от 140 тысяч до 190 тысяч специалистов, обладающих глубокими аналитическими познаниями, а также 1,5 миллиона менеджеров и аналитиков, которые бы анализировали большие данные и принимали решения на основании полученных результатов»2. Такое положение дел сохраняется. В отчете за август 2018 года «LinkedIn Workforce Report» сказано, что в Соединенных Штатах существует нехватка более 150 тысяч специалистов в области data science3. В отчете IBM, Burning Glass Technologies и Business-Higher Education Forum за 2017 года говорится, что к 2020 году в Соединенных Штатах будут существовать сотни тысяч вакансий, требующих квалификации в области data science4.

Модульная структура

Модульная структура книги обеспечивает потребности разных профессиональных аудиторий.

Главы 1–10 посвящены программированию на языке Python. Каждая из этих глав содержит краткий раздел «Введение в data science»; в этих разделах будут представлены такие темы, как искусственный интеллект, основные характеристики описательной статистики, метрики, характеризующие положение центра распределения и разброс, моделирование, статические и динамические визуализации, работа с файлами CSV, применение Pandas для исследования и первичной обработки данных, временные ряды и простая линейная регрессия. Эти разделы подготовят вас к изучению data science, искусственного интеллекта, больших данных и облачных технологий в главах 11–16, в которых вам представится возможность применить реальные наборы данных в полноценных практических примерах.

После описания Python в главах 1–5 и некоторых ключевых частей глав 6–7 вашей подготовки будет достаточно для основных частей практических примеров в главах 11–16. Раздел «Зависимость между главами» данного предисловия поможет преподавателям спланировать свои профессиональные курсы в контексте уникальной архитектуры книги.

Главы 11–16 переполнены занимательными, современными примерами. В них представлены практические реализации по таким темам, как обработка естественного языка, глубокий анализ данных Twitter, когнитивные вычисления на базе IBM Watson, машинное обучение с учителем для решения задач классификации и регрессии, машинное обучение без учителя для решения задач кластеризации, глубокое обучение на базе сверточных нейронных сетей, глубокое обучение на базе рекуррентных нейронных сетей, большие данные с Hadoop, Spark и баз данных NoSQL, «интернет вещей» и многое другое. Попутно вы освоите широкий спектр терминов и концепций data science, от кратких определений до применения концепций в малых, средних и больших программах. Подробное оглавление книги даст вам представление о широте изложения.

Ключевые особенности

• Простота: в каждом аспекте книги мы ставили на первое место простоту и ясность. Например, для обработки естественного языка мы используем простую и интуитивную библиотеку TextBlob вместо более сложной библиотеки NLTK. При описании глубокого обучения мы отдали предпочтение Keras перед TensorFlow. Как правило, если для решения какой-либо задачи можно было воспользоваться несколькими разными библиотеками, мы выбирали самый простой вариант.

• Компактность: большинство из 538 примеров этой книги невелики — они состоят всего из нескольких строк кода с немедленным интерактивным откликом от IPython. Также в книгу включены 40 больших сценариев и подробных практических примеров.

• Актуальность: мы прочитали множество книг о программировании Python и data science; просмотрели или прочитали около 15 000 статей, исследовательских работ, информационных документов, видеороликов, публикаций в блогах, сообщений на форумах и документов. Это позволило нам «держать руку на пульсе» сообществ Python, компьютерных технологий, data science, AI, больших данных и облачных технологий.

Быстрый отклик: исследования и эксперименты с IPython

• Если вы хотите учиться по этой книге, лучше всего читать текст и параллельно выполнять примеры кода. В этой книге используется интерпретатор IPython, который предоставляет удобный интерактивный режим с немедленным откликом для быстрых исследований и экспериментов с Python и обширным набором библиотек.

• Большая часть кода представлена в виде небольших интерактивных сеансов IPython. IPython немедленно читает каждый фрагмент кода, написанный вами, обрабатывает его и выводит результаты. Мгновенная обратная связь помогает сосредоточиться, повышает эффективность обучения, способствует быстрой прототипизации и ускоряет процесс разработки.

• В наших книгах на первый план всегда выходит живой код и ориентация на полноценные работоспособные программы с реальным вводом и выводом. «Волшебство» IPython как раз и заключается в том, что он превращает фрагменты в код, который «оживает» с каждой введенной строкой. Такой результат повышает эффективность обучения и поощряет эксперименты.

Основы программирования на Python

• Прежде всего в книге достаточно глубоко и подробно излагаются основы Python.

• В ней рассматриваются модели программирования на языке Python — процедурное программирование, программирование в функциональном стиле и объектно-ориентированное программирование.

• Мы стараемся наглядно выделять текущие идиомы.

• Программирование в функциональном стиле используется везде, где это уместно. На диаграмме в главе 4 перечислены ключевые средства программирования в функциональном стиле языка Python с указанием глав, в которых они впервые рассматриваются.

538 примеров кода

• Увлекательное, хотя и непростое введение в Python подкрепляется 538 реальными примерами — от небольших фрагментов до основательных практических примеров из области компьютерной теории, data science, искусственного интеллекта и больших данных.

• Мы займемся нетривиальными задачами из области искусственного интеллекта, больших данных и облачных технологий, такими как обработка естественного языка, глубокий анализ данных Twitter, машинное обучение, глубокое обучение, Hadoop, MapReduce, Spark, IBM Watson, ключевые библиотеки data science (NumPy, pandas, SciPy, NLTK, TextBlob, spaCy, Textatistic, Tweepy, Scikit-learn, Keras), ключевые библиотеки визуализации (Matplotlib, Seaborn, Folium) и т.д.

Объяснения вместо математических выкладок

• Мы стараемся сформулировать концептуальную сущность математических вычислений и использовать ее в своих примерах. Для этого применяются такие библиотеки, как statistics, NumPy, SciPy, pandas и многие другие, скрывающие математические сложности от пользователя. Таким образом, вы сможете пользоваться такими математическими методами, как линейная регрессия, даже не владея математической теорией, на которой они базируются. В примерах машинного обучения мы стараемся создавать объекты, которые выполнят все вычисления за вас.

Визуализации

• 67 статических, динамических, анимированных и интерактивных визуализаций (диаграмм, графиков, иллюстраций, анимаций и т.д.) помогут вам лучше понять концепции.

• Вместо того чтобы подолгу объяснять низкоуровневое графическое программирование, мы сосредоточимся на высокоуровневых визуализациях, построенных средствами Matplotlib, Seaborn, pandas и Folium (для интерактивных карт).

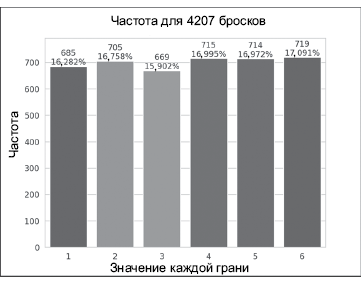

• Визуализации используются как учебный инструмент. Например, закон больших чисел наглядно демонстрируется динамической моделью бросков кубиков и построением гистограммы. С увеличением количества бросков процент выпадений каждой грани постепенно приближается к 16,667% (1/6), а размеры столбцов, представляющих эти проценты, постепенно выравниваются.

• Визуализации чрезвычайно важны при работе с большими данными: они упрощают исследование данных и получение воспроизводимых результатов исследований, когда количество элементов данных может достигать миллионов, миллиардов и более. Часто говорят, что одна картинка стоит тысячи слов5 — в мире больших данных визуализация может стоить миллиардов, триллионов и даже более записей в базе данных. Визуализации позволяют взглянуть на данные «с высоты птичьего полета», увидеть их «в перспективе» и составить о них представление. Описательные статистики полезны, но иногда могут увести в ошибочном направлении. Например, квартет Энскомба6 демонстрирует посредством визуализаций, что серьезно различающиеся наборы данных могут иметь почти одинаковые показатели описательной статистики.

• Мы приводим код визуализаций и анимаций, чтобы вы могли реализовать собственные решения. Также анимации предоставляются в виде файлов с исходным кодом и документов Jupyter Notebook, чтобы вам было удобно настраивать код и параметры анимаций, заново выполнить анимации и понаблюдать за эффектом изменений.

Опыт работы с данными

• В разделах «Введение в data science» и практических примерах из глав 11–16 вы получите полезный опыт работы с данными.

• Мы будем работать со многими реальными базами данных и источниками данных. В интернете существует огромное количество бесплатных открытых наборов данных, с которыми вы можете экспериментировать. На некоторых сайтах, упомянутых нами, приводятся ссылки на сотни и тысячи наборов данных.

• Многие библиотеки, которыми вы будете пользоваться, включают популярные наборы данных для экспериментов.

• В книге мы рассмотрим действия, необходимые для получения данных и подготовки их к анализу, анализ этих данных различными средствами, настройки моделей и эффективных средств передачи результатов, особенно посредством визуализации.

GitHub

• GitHub — превосходный ресурс для поиска открытого кода, который вы сможете интегрировать в свои проекты (а также поделиться своим кодом с сообществом). Также GitHub является важнейшим элементом арсенала разработчика с функциональностью контроля версий, которая помогает командам разработчиков управлять проектами с открытым (и закрытым) кодом.

• Мы будем использовать множество разнообразных библиотек Python и data science, распространяемых с открытым кодом, а также программных продуктов и облачных сервисов — бесплатных, имеющих пробный период и условно-бесплатных. Многие библиотеки размещаются на GitHub.

Практические облачные вычисления

• Большая часть аналитики больших данных выполняется в облачных средах, позволяющих легко динамически масштабировать объем аппаратных и программных ресурсов, необходимых вашему приложению. Мы будем работать с различными облачными сервисами (напрямую или опосредованно), включая Twitter, Google Translate, IBM Watson, Microsoft Azure, OpenMapQuest, geopy, Dweet.io и PubNub.

• Мы рекомендуем пользоваться бесплатными, имеющими пробный период или условно-бесплатными сервисами. Предпочтение отдается тем сервисам, которые не требуют ввода данных кредитной карты, чтобы избежать получения больших счетов. Если же вы решили использовать сервис, требующий ввода данных кредитной карты, убедитесь в том, что с выбранного вами бесплатного уровня не происходит автоматический переход на платный уровень.

Базы данных, большие данные и инфраструктура больших данных

• По данным IBM (ноябрь 2016 года), 90% мировых данных было создано за последние два года7. Факты показывают, что скорость создания данных стремительно растет.

• По данным статьи AnalyticsWeek за март 2016 года, в течение 5 лет к интернету будет подключено более 50 миллиардов устройств, а к 2020 году в мире будет ежесекундно производиться 1,7 мегабайт новых данных на каждого человека8!

• В книге рассматриваются основы работы с реляционными базами данных и использования SQL с SQLite.

• Базы данных — критический элемент инфраструктуры больших данных для хранения и обработки больших объемов информации. Реляционные базы данных предназначены для обработки структурированных данных — они не приспособлены для неструктурированных и полуструктурированных данных в приложениях больших данных. По этой причине с развитием больших данных были созданы базы данных NoSQL и NewSQL для эффективной работы с такими данными. Мы приводим обзор NoSQL и NewSQL, а также практический пример работы с документной базой данных MongoDB в формате JSON. MongoDB — самая популярная база данных NoSQL.

• Оборудование и программная инфраструктура больших данных рассматриваются в главе 16.

Практические примеры из области искусственного интеллекта

• В практических примерах глав 11–15 представлены темы искусственного интеллекта, включая обработку естественного языка, глубокий анализ данных Twitter для анализа эмоциональной окраски, когнитивные вычисления на базе IBM Watson, машинное обучение с учителем, машинное обучение без учителя и глубокое обучение. В главе 16 представлено оборудование больших данных и программная инфраструктура, которые позволяют специалистам по компьютерным технологиям и теоретикам data science реализовать ультрасовременные решения на базе искусственного интеллекта.

Встроенные коллекции: списки, кортежи, множества, словари

• Как правило, в наши дни самостоятельная реализация структур данных не имеет особого смысла. В книге приведено подробное, состоящее из двух глав описание встроенных структур данных Python — списков, кортежей, словарей и множеств, успешно решающих большинство задач структурирования данных.

Программирование с использованием массивов NumPy и коллекций pandas Series/DataFrame

• Мы также уделили особое внимание трем ключевым структурам данных из библиотек с открытым кодом: массивам NumPy, коллекциям pandas Series и pandas DataFrame. Эти коллекции находят широкое применение в data science, компьютерной теории, искусственном интеллекте и больших данных. NumPy обеспечивает эффективность на два порядка выше, чем у встроенных списков Python.

• В главу 7 включено подробное описание массивов NumPy. Многие библиотеки, например pandas, построены на базе NumPy. В разделах «Введение в data science» в главах 7–9 представлены коллекции pandas Series и DataFrame, которые хорошо работают в сочетании с массивами NumPy, а также используются в оставшихся главах.

Работа с файлами и сериализация

• В главе 9 рассказывается об обработке текстовых файлов, а затем показано, как сериализовать объекты в популярном формате JSON (JavaScript Object Notation). JSON часто используется в части, посвященной data science.

• Многие библиотеки data science предоставляют встроенные средства для работы с файлами и загрузки наборов данных в программы Python. Кроме простых текстовых файлов, мы также займемся обработкой файлов в популярном формате CSV (значения, разделенные запятыми) с использованием модуля csv стандартной библиотеки Python и средств библиотеки data science pandas.

Объектно-базированное программирование

• Мы стараемся использовать многочисленные классы, упакованные сообществом разработки с открытым кодом Python в библиотеки классов. Прежде всего мы разберемся в том, какие библиотеки существуют, как выбрать библиотеки, подходящие для ваших приложений, как создать объекты существующих классов (обычно в одной-двух строках кода) и пустить их в дело. Объектно-базированный стиль программирования позволяет быстро и компактно строить впечатляющие приложения, что является одной из важных причин популярности Python.

• Этот подход позволит вам применять машинное обучение, глубокое обучение и другие технологии искусственного интеллекта для быстрого решения широкого спектра интересных задач, включая такие задачи когнитивных вычислений, как распознавание речи и «компьютерное зрение».

Объектно-ориентированное программирование

• Разработка собственных классов — важнейшая составляющая объектно-ориентированного программирования наряду с наследованием, полиморфизмом и утиной типизацией. Эти составляющие рассматриваются в главе 10.

• В главе 10 рассматривается модульное тестирование с использованием doctest и интересного моделирования процесса тасования и раздачи карт.

• Для целей глав 11–16 хватает нескольких простых определений пользовательских классов. Вероятно, в коде Python вы будете применять объектно-базированное программирование чаще, чем полноценное объектно-ориентированное программирование.

Воспроизводимость результатов

• В науке вообще и в data science в частности существует потребность в воспроизведении результатов экспериментов и исследований, а также эффективном распространении этих результатов. Для этого обычно рекомендуется применять документы Jupyter Notebook.

• Воспроизводимость результатов рассматривается в книге в контексте методов программирования и программных средств, таких как документы Jupyter Notebook и Docker.

Эффективность

• В нескольких примерах используется средство профилирования %timeit для сравнения эффективности разных подходов к решению одной задачи. Также рассматриваются такие средства, относящиеся к эффективности, как выражения-генераторы, сравнение массивов NumPy со списками Python, эффективность моделей машинного обучения и глубокого обучения, эффективность распределенных вычислений Hadoop и Spark.

Большие данные и параллелизм

В этой книге вместо написания собственного кода параллелизации мы поручим таким библиотекам, как Keras на базе TensorFlow, и таким инструментам больших данных, как Hadoop и Spark, провести параллелизацию за вас. В эру больших данных/искусственного интеллекта колоссальные требования к вычислительным мощностям приложений, работающих с большими массивами данных, заставляют нас задействовать полноценный параллелизм, обеспечиваемый многоядерными процессорами, графическими процессорами (GPU), тензорными процессорами (TPU) и гигантскими компьютерными кластерами в облаке. Некоторые задачи больших данных могли требовать параллельной работы тысяч процессоров для быстрого анализа огромных объемов данных.

Зависимость между главами

Допустим, вы — преподаватель, составляющий план лекций для профессиональных учебных курсов, или разработчик, решающий, какие главы следует читать в первую очередь. Тогда этот раздел поможет вам принять оптимальные решения. Главы лучше всего читать (или использовать для обучения) по порядку. Тем не менее для большей части материала разделов «Введение в data science» в конце глав 1–10 и практических примеров в главах 11–16 необходимы только главы 1–5 и небольшие части глав 6–10.

Часть 1: Основы Python

Мы рекомендуем читать все главы по порядку:

• В главе 1 «Компьютеры и Python» представлены концепции, которые закладывают фундамент для программирования на языке Python в главах 2–10 и практических примеров больших данных, искусственного интеллекта и облачных сервисов в главах 11–16. В главе также приведены результаты пробных запусков интерпретатора IPython и документов Jupyter Notebook.

• В главе 2 «Введение в программирование Python» изложены основы программирования Python с примерами кода, демонстрирующими ключевые возможности языка.

• В главе 3 «Управляющие команды» представлены управляющие команды Python и простейшие возможности обработки списков.

• В главе 4 «Функции» представлены пользовательские функции, методы моделирования с генерированием случайных чисел и основы работы с кортежами.

• В главе 5 «Последовательности: списки и кортежи» встроенные списки и кортежи Python описаны более подробно. Также в ней начинается изложение азов программирования в функциональном стиле.

Часть 2: Структуры данных Python, строки и файлы

Ниже приведена сводка зависимостей между главами для глав 6–9; предполагается, что вы уже прочитали главы 1–5.

• Глава 6 «Словари и множества» — раздел «6.4. Введение в data science» этой главы не зависит от материала главы.

• Глава 7 «NumPy и программирование, ориентированное на массивы» — для раздела «7.14. Введение в data science» необходимо знание словарей (глава 6) и массивов (глава 7).

• Глава 8 «Подробнее о строках» — для раздела «8.13. Введение в data science» необходимо знание необработанных строк и регулярных выражений (разделы 8.11–8.12), а также коллекций pandas Series и DataFrame из раздела 7.14.

• Глава 9 «Файлы и исключения» — для изучения сериализации JSON полезно знать основы работы со словарями (раздел 6.2). Кроме того, раздел «9.12. Введение в data science» требует знания встроенной функции open и команды with (раздел 9.3), а также коллекций pandas Series и DataFrame из раздела 7.14.

Часть 3: Нетривиальные аспекты Python

Ниже приведена сводка зависимостей между главами для глав 10; предполагается, что вы уже прочитали главы 1–5.

• Глава 10 «Объектно-ориентированное программирование» — раздел «Введение в data science» требует знания возможностей DataFrame из раздела 7.14. Преподаватели, которые намерены ограничиваться рассмотрением только классов и объектов, могут изложить материал разделов 10.1–10.6. Для преподавателей, которые собираются изложить более сложные темы (наследование, полиморфизм, утиная типизация), могут представлять интерес разделы 10.7–10.9. В разделах 10.10–10.15 изложены дополнительные перспективы.

Часть 4: Искусственный интеллект, облачные технологии и практические примеры больших данных

Ниже приведена сводка зависимостей между главами для глав 11–16; предполагается, что вы уже прочитали главы 1–5. Большинство глав 11–16 также требует знания словарей из раздела 6.2.

• В главе 11 «Обработка естественного языка» используются возможности pandas DataFrame из раздела 7.14.

• В главе 12 «Глубокий анализ данных Twitter» используются возможности pandas DataFrame из раздела 7.14, метод строк join (раздел 8.9), основы работы с JSON (раздел 9.5), TextBlob (раздел 11.2) и словарные облака (раздел 11.3). Некоторые примеры требуют определения классов с наследованием (глава 10).

• В главе 13 «IBM Watson и когнитивные вычисления» используется встроенная функция open и команда with (раздел 9.3).

• В главе 14 «Машинное обучение: классификация, регрессия и кластеризация» используются основные средства работы с массивами NumPy и метод unique (глава 7), возможности pandas DataFrame из раздела 7.14, а также функция subplots библиотеки Matplotlib (раздел 10.6).

• В главе 15 «Глубокое обучение» используются основные средства работы с массивами NumPy (глава 7), метод строк join (раздел 8.9), общие концепции машинного обучения из главы 14 и функциональность из практического примера главы 14 «Классификация методом k ближайших соседей и набор данных Digits».

• В главе 16 «Большие данные: Hadoop, Spark, NoSQL и IoT» используется метод строк split (раздел 6.2.7), объект Matplotlib FuncAnimation из раздела 6.4, коллекции pandas Series и DataFrame из раздела 7.14, метод строк join (раздел 8.9), модуль json (раздел 9.5), игнорируемые слова NLTK (раздел 11.2.13), аутентификация Twitter из главы 12, класс Tweepy StreamListener для потоковой передачи твитов, а также библиотеки geopy и folium. Некоторые примеры требуют определения классов с применением наследования (глава 10), но вы можете просто повторить наши определения классов без чтения главы 10.

Документы Jupyter Notebook

Для вашего удобства мы предоставили примеры кода книги в файлах с исходным кодом Python (.py) для использования с интерпретатором командной строки IPython, а также файлы Jupyter Notebook (.ipynb), которые можно загрузить в браузере и выполнить.

Jupyter Notebook — бесплатный проект с открытым кодом, который позволяет объединять текст, графику, аудио, видео и функциональность интерактивного программирования для быстрого и удобного ввода, редактирования, выполнения, отладки и изменения кода в браузере. Фрагмент статьи «Что такое Jupyter?»:

«Jupyter стал фактическим стандартом для научных исследований и анализа данных. Вычисления упаковываются вместе с аргументами, позволяя вам строить “вычислительные нарративы”; …это упрощает проблему распространения работоспособного кода между коллегами и участниками сообщества»9.

Наш опыт показывает, что эта среда прекрасно подходит для обучения и быстрой прототипизации. По этой причине мы используем документы Jupyter Notebook вместо традиционных интегрированных сред (IDE), таких как Eclipse, Visual Studio, PyCharm или Spyder. Ученые и специалисты уже широко применяют Jupyter для распространения результатов своих исследований. Поддержка Jupyter Notebook предоставляется через традиционные механизмы сообщества с открытым кодом10 (см. раздел «Поддержка Jupyter» в этом предисловии). За подробным описанием установки обращайтесь к разделу «Приступая к работе» после предисловия, а информация о запуске примеров книги приведена в разделе 1.5.

Совместная работа и обмен результатами

Работа в команде и распространение результатов исследований играют важную роль для разработчиков, которые занимают или собираются занять должность, связанную с аналитикой данных, в коммерческих, правительственных или образовательных организациях:

• Созданные вами документы Notebook удобно распространять среди участников команды простым копированием файлов или через GitHub.

• Результаты исследований, включая код и аналитику, могут публиковаться в виде статических веб-страниц при помощи таких инструментов, как nbviewer (https://nbviewer.jupyter.org) и GitHub, — оба ресурса автоматически визуализируют документы Notebook в виде веб-страниц.

Воспроизводимость результатов: веский аргумент в пользу Jupyter Notebook

В области data science и научных дисциплин вообще эксперименты и исследования должны быть воспроизводимыми. Об этом неоднократно упоминалось в литературе:

• Публикация Дональда Кнута «Грамотное программирование» в 1992 году11.

• Статья «Языково-независимый воспроизводимый анализ данных с применением грамотного программирования»12, в которой сказано: «Lir-вычисления (грамотные воспроизводимые вычисления) базируются на концепции грамотного программирования, предложенной Дональдом Кнутом».

По сути, воспроизводимость отражает полное состояние среды, использованной для получения результатов: оборудование, программное обеспечение, коммуникации, алгоритмы (особенно код), данные и родословная данных (источник и линия происхождения).

Docker

В главе 16 используется Docker — инструмент для упаковки программного кода в контейнеры, содержащие все необходимое для удобного, воспроизводимого и портируемого выполнения этого кода между платформами. Некоторые программные пакеты, используемые в главе 16, требуют сложной подготовки и настройки. Для многих из них можно бесплатно загрузить готовые контейнеры Docker. Это позволяет избежать сложных проблем установки и запускать программные продукты локально на настольном или портативном компьютере. Docker предоставляет идеальную возможность быстро и удобно приступить к использованию новых технологий.

Docker также помогает обеспечить воспроизводимость. Вы можете создавать специализированные контейнеры Docker с нужными версиями всех программных продуктов и всех библиотек, использованных в исследовании. Это позволит другим разработчикам воссоздать использованную вами среду, а затем повторить вашу работу и получить ваши результаты. В главе 16 мы используем Docker для загрузки и выполнения контейнера, заранее настроенного для программирования и запуска Spark-приложений больших данных на базе Jupyter Notebook.

IBM Watson и когнитивные вычисления

На ранней стадии исследований, проводимых для этой книги, мы распознали быстро растущий интерес к IBM Watson. Мы проанализировали предложения конкурентов и обнаружили, что политика Watson «без ввода данных кредитной карты» для бесплатных уровней является одной из самых удобных для наших читателей.

IBM Watson — платформа когнитивных вычислений, применяемая в широком спектре реальных сценариев. Системы когнитивных вычислений моделируют функции человеческого мозга по выявлению закономерностей и принятию решений для «обучения» с поглощением большего объема данных13,14,15. В книге Watson уделяется значительное внимание. Мы используем бесплатный пакет Watson Developer Cloud: Python SDK, который предоставляет различные API для взаимодействия с сервисами Watson на программном уровне. С Watson интересно работать, и эта платформа помогает раскрыть ваш творческий потенциал.

Сервисы Watson уровня Lite и практический пример Watson

Чтобы способствовать обучению и экспериментам, IBM предоставляет бесплатные lite-уровни для многих своих API16. В главе 13 будут опробованы демонстрационные приложения для многих сервисов Watson17. Затем мы используем lite-уровни сервисов Watson Text to Speech, Speech to Text и Translate для реализации приложения-переводчика. Пользователь произносит вопрос на английском языке, приложение преобразует речь в английский текст, переводит текст на испанский язык и зачитывает испанский текст. Собеседник произносит ответ на испанском языке (если вы не говорите на испанском, мы предоставили аудиофайл, который вы можете использовать). Приложение быстро преобразует речь в испанский текст, переводит текст на английский и зачитывает ответ на английском. Круто!

Подход к обучению

«Python: Искусственный интеллект, большие данные и облачные вычисления» содержит обширную подборку примеров, позаимствованных из многих областей. Мы рассмотрим некоторые интересные примеры с реальными наборами данных. В книге основное внимание уделяется принципам качественного проектирования программных продуктов, а на передний план выходит ясность кода.

538 примеров кода

538 примеров, приведенных в книге, содержат приблизительно 4000 строк кода. Это относительно небольшой объем для книги такого размера, что отчасти объясняется выразительностью языка Python. Кроме того, наш стиль программирования подразумевает, что мы по возможности используем полнофункциональные библиотеки классов; эти библиотеки берут на себя большую часть работы.

160 таблиц/иллюстраций/визуализаций

В книгу включено множество таблиц, графиков, а также статических, динамических и интерактивных визуализаций.

Житейская мудрость программирования

В материал книги интегрируется житейская мудрость программирования, основанная на девяти десятилетиях (в сумме) авторского опыта программирования и преподавания.

• Хороший стиль программирования и общепринятые идиомы Python помогают создавать более понятные, более четкие и простые в сопровождении программы.

• Описание распространенных ошибок программирования снижает вероятность того, что эти ошибки будут допущены читателями.

• Советы по предотвращению ошибок с рекомендациями по выявлению дефектов и исключению их из программ. Во многих советах описываются приемы, которые препятствуют изначальному проникновению ошибок в ваши программы.

• Советы по быстродействию, в которых выделяются возможности для ускорения работы ваших программ или сокращения объема занимаемой памяти.

• Наблюдения из области программирования, в которых выделяются архитектурные и проектировочные аспекты правильного построения программных продуктов (особенно для больших систем).

Программные продукты, используемые в книге

Программные продукты, используемые в книге, доступны для Windows, macOS и Linux, и их можно бесплатно загрузить из интернета. Для написания примеров используется бесплатный дистрибутив Anaconda Python. Он включает большую часть Python, библиотек визуализации и data science, которые вам понадобятся, а также интерпретатор IPython, Jupyter Notebook и Spyder — одну из самых лучших интегрированных сред Python для data science. Для разработки программ, приведенных в книге, используется только IPython и Jupyter Notebook. В разделе «Приступая к работе» после предисловия обсуждается установка Anaconda и других продуктов, необходимых для работы с нашими примерами.

Документация Python

Следующая документация особенно пригодится вам во время работы с книгой:

• Справочник по языку Python:

https://docs.python.org/3/reference/index.html

• Стандартная библиотека Python:

https://docs.python.org/3/library/index.html

• Список документации Python:

Ответы на вопросы

Несколько популярных форумов, посвященных Python и программированию вообще:

• python-forum.io

• https://www.dreamincode.net/forums/forum/29-python/

• StackOverflow.com

Кроме того, многие разработчики открывают форумы по своим инструментариям и библиотекам. Управление и сопровождение многих библиотек, используемых в книге, осуществляется через github.com. Для некоторых библиотек поддержка предоставляется через вкладку Issues на странице GinHub этих библиотек. Если вы не найдете ответ на свои вопросы, посетите веб-страницу этой книги на сайте

Поддержка Jupyter

Поддержка Jupyter Notebook предоставляется на следующих ресурсах:

• Project Jupyter Google Group:

https://groups.google.com/forum/#!forum/jupyter

• Jupyter-чат в реальном времени:

https://gitter.im/jupyter/jupyter

• GitHub

https://github.com/jupyter/help

• StackOverflow:

https://stackoverflow.com/questions/tagged/jupyter

• Jupyter for Education Google Group (для преподавателей, использующих Jupyter в ходе обучения):

https://groups.google.com/forum/#!forum/jupyter-education

Приложения

Чтобы извлечь максимум пользы из материала, выполняйте каждый пример кода параллельно с соответствующим описанием в книге. На веб-странице книги на сайте

предоставляются:

• исходный код Python (файлы .py), подготовленный к загрузке, и документы Jupyter Notebook (файлы .ipynb) для примеров кода;

• видеоролики, поясняющие использование примеров кода с IPython и документами Jupyter Notebook. Эти инструменты также описаны в разделе 1.5;

• сообщения в блогах и обновления книги.

За инструкциями по загрузке обращайтесь к разделу «Приступая к работе» после предисловия.

Как связаться с авторами книги

Мы ждем ваши комментарии, критические замечания, исправления и предложения по улучшению книги. С вопросами, найденными опечатками и предложениями обращайтесь по адресу: deitel@deitel.com.

Или ищите нас в соцсетях:

• Facebook® (http://www.deitel.com/deitelfan)

• Twitter® (@deitel)

• LinkedIn® (http://linkedin.com/company/deitel-&-associates)

• YouTube® (http://youtube.com/DeitelTV)

Благодарности

Спасибо Барбаре Дейтел (Barbara Deitel) за долгие часы, проведенные в интернете за поиском информации по проекту. Нам повезло работать с группой профессионалов из издательства Pearson. Мы высоко ценим все усилия и 25-летнее наставничество нашего друга и профессионала Марка Л. Тауба (Mark L. Taub), вице-президента издательской группы Pearson IT Professional Group. Марк со своей группой работает над всеми нашими профессиональными книгами, видеоуроками и учебными руководствами из сервиса Safari (https://learning.oreilly.com/). Они также являются спонсорами наших обучающих семинаров в Safari. Джули Наил (Julie Nahil) руководила выпуском книги. Мы выбрали иллюстрацию для обложки, а дизайн обложки был разработан Чати Презертсит (Chuti Prasertshith).

Мы хотим выразить свою благодарность своим редакторам. Патрисия Байрон-Кимболл (Patricia Byron-Kimball) и Меган Джейкоби (Meghan Jacoby) подбирали научных рецензентов и руководили процессом рецензирования. Держась в рамках жесткого графика, редакторы рецензировали нашу работу, делились многочисленными замечаниями для повышения точности, полноты и актуальности материала.

Научные редакторы

Книга

Дэниел Чен (Daniel Chen), специалист по data science, Lander Analytics

Гаррет Дансик (Garrett Dancik), доцент кафедры компьютерных наук/биоинформатики, Университет Восточного Коннектикута

Праншу Гупта (Pranshu Gupta), доцент кафедры компьютерных наук, Университет Десалс

Дэвид Куп (David Koop), доцент кафедры data science, содиректор по учебным программам, Университет Массачусетса в Дартмуте

Рамон Мата-Толедо (Ramon Mata-Toledo), профессор кафедры компьютерных наук, Университет Джеймса Мэдисона

Шьямал Митра (Shyamal Mitra), старший преподаватель кафедры компьютерных наук, Техасский университет в Остине

Элисон Санчес (Alison Sanchez), доцент кафедры экономики, Университет Сан-Диего

Хосе Антонио Гонсалес Секо (José Antonio González Seco), IT-консультант

Джейми Уайтакер (Jamie Whitacre), независимый консультант в области data science

Элизабет Уикс (Elizabeth Wickes), преподаватель, школа информатики, Университет штата Иллинойс

Черновик

Ирен Бруно (Dr. Irene Bruno), доцент кафедры информатики и информационных технологий, Университет Джорджа Мэйсона

Ланс Брайант (Lance Bryant), доцент кафедры математики, Шиппенсбургский университет

Дэниел Чен (Daniel Chen), специалист по data science, Lander Analytics

Гаррет Дансик (Garrett Dancik), доцент кафедры компьютерных наук/биоинформатики, Университет Восточного Коннектикута

Марша Дэвис (Dr. Marsha Davis), декан математического факультета, Университет Восточного Коннектикута

Роланд ДеПратти (Roland DePratti), доцент кафедры компьютерных наук, Университет Восточного Коннектикута

Шьямал Митра (Shyamal Mitra), старший преподаватель, Техасский университет в Остине

Марк Поли (Dr. Mark Pauley), старший научный сотрудник на кафедре биоинформатики, школа междисциплинарной информатики, Университет штата Небраска в Омахе

Шон Рейли (Sean Raleigh), доцент кафедры математики, заведующий кафедрой data science, Вестминстерский колледж

Элисон Санчес (Alison Sanchez), доцент кафедры экономики, Университет Сан-Диего

Харви Сай (Dr. Harvey Siy), доцент кафедры компьютерных наук, информатики и информационных технологий, Университет штата Небраска в Омахе

Джейми Уайтакр (Jamie Whitacre), независимый консультант в области data science

Мы будем благодарны за ваши комментарии, критику, исправления и предложения по улучшению. Если у вас возникают какие-либо вопросы, обращайтесь по адресу deitel@deitel.com.

Добро пожаловать в увлекательный мир разработки Python с открытым кодом. Надеемся, вам понравится эта книга, посвященная разработке современных приложений Python с использованием IPython и Jupyter Notebook и затрагивающая вопросы data science, искусственного интеллекта, больших данных и облачных технологий. Желаем успеха!

Пол и Харви Дейтелы

Об авторах

Пол Дж. Дейтел (Paul J. Deitel), генеральный и технический директор компании Deitel & Associates, Inc., окончил Массачусетский технологический институт (MIT), более 38 лет занимается компьютерами. Пол — один из самых опытных преподавателей языков программирования, он ведет учебные курсы для разработчиков с 1992 года. Он провел сотни занятий по всему миру для корпоративных клиентов, включая Cisco, IBM, Siemens, Sun Microsystems (сейчас Oracle), Dell, Fidelity, NASA (Космический центр имени Кеннеди), Национальный центр прогнозирования сильных штормов, ракетный полигон Уайт-Сэндз, Rogue Wave Software, Boeing, Nortel Networks, Puma, iRobot и многих других. Пол и его соавтор, д-р Харви М. Дейтел, являются авторами всемирно известных бестселлеров — учебников по языкам программирования, предназначенных для начинающих и для профессионалов, а также видеокурсов.

Харви М. Дейтел (Dr. Harvey M. Deitel), председатель и главный стратег компании Deitel & Associates, Inc., имеет 58-летний опыт работы в области информационных технологий. Он получил степени бакалавра и магистра Массачусетского технологического института и степень доктора философии Бостонского университета — он изучал компьютерные технологии во всех этих программах до того, как в них появились отдельные программы компьютерных наук. Харви имеет огромный опыт преподавания в колледже и занимал должность председателя отделения информационных технологий Бостонского колледжа. В 1991 году вместе с сыном — Полом Дж. Дейтелом — он основал компанию Deitel & Associates, Inc. Харви с Полом написали несколько десятков книг и выпустили десятки видеокурсов LiveLessons. Написанные ими книги получили международное признание и были изданы на японском, немецком, русском, испанском, французском, польском, итальянском, упрощенном китайском, традиционном китайском, корейском, португальском, греческом, турецком языках и на языке урду. Дейтел провел сотни семинаров по программированию в крупных корпорациях, академических институтах, правительственных и военных организациях.

О компании Deitel® & Associates, Inc.

Компания Deitel & Associates, Inc., основанная Полом Дейтелом и Харви Дейтелом, получила международное признание в области авторских разработок и корпоративного обучения. Компания специализируется на языках программирования, объектных технологиях, интернете и веб-программировании. В число клиентов компании входят многие ведущие корпорации, правительственные агентства, военные и образовательные учреждения. Компания предоставляет учебные курсы, проводимые на территории клиента по всему миру для многих языков программирования и платформ.

Благодаря своему 44-летнему партнерскому сотрудничеству с Pearson/Prentice Hall, компания Deitel & Associates, Inc., публикует передовые учебники по программированию и профессиональные книги в печатном и электронном виде, видеокурсы LiveLessons (доступны для покупки на https://www.informit.com), Learning Paths и интерактивные обучающие семинары в режиме реального времени в службе Safari (https://learning.oreilly.com) и интерактивные мультимедийные курсы Revel™.

Чтобы связаться с компанией Deitel & Associates, Inc. и авторами или запросить план-проспект или предложение по обучению, напишите: deitel@deitel.com

Чтобы узнать больше о корпоративном обучении Дейтелов, посетите

http://www.deitel.com/training.

Желающие приобрести книги Дейтелов, могут сделать это на

Крупные заказы корпораций, правительства, военных и академических учреждений следует размещать непосредственно на сайте Pearson. Для получения дополнительной информации посетите

https://www.informit.com/store/sales.aspx.

1 Источник неизвестен, часто ошибочно приписывается Марку Твену.

2https://www.mckinsey.com/~/media/McKinsey/Business%20Functions/McKinsey%20Digital/Our%20Insights/Big%20data%20The%20next%20frontier%20for%20innovation/MGI_big_data_full_report.ashx (с. 3).

7https://public.dhe.ibm.com/common/ssi/ecm/wr/en/wrl12345usen/watson-customer-engagement-watson-marketing-wr-other-papers-and-reports-wrl12345usen-20170719.pdf.

15https://www.forbes.com/sites/bernardmarr/2016/03/23/what-everyone-should-know-about-cognitive-computing.

16 Всегда проверяйте последние условия предоставления сервиса на сайте IBM, так как условия и сервисы могут меняться со временем.

18 Наш сайт сейчас проходит серьезную переработку. Если вы не найдете нужную информацию, обращайтесь к нам по адресу deitel@deitel.com.

Источник неизвестен, часто ошибочно приписывается Марку Твену.

Наш сайт сейчас проходит серьезную переработку. Если вы не найдете нужную информацию, обращайтесь к нам по адресу deitel@deitel.com.

Всегда проверяйте последние условия предоставления сервиса на сайте IBM, так как условия и сервисы могут меняться со временем.

«Там золото в этих холмах!»1

В 2011 году Глобальный институт McKinsey опубликовал отчет «Большие данные: новый рубеж для инноваций, конкуренции и производительности». В отчете было сказано: «Только Соединенные Штаты сталкиваются с нехваткой от 140 тысяч до 190 тысяч специалистов, обладающих глубокими аналитическими познаниями, а также 1,5 миллиона менеджеров и аналитиков, которые бы анализировали большие данные и принимали решения на основании полученных результатов»2. Такое положение дел сохраняется. В отчете за август 2018 года «LinkedIn Workforce Report» сказано, что в Соединенных Штатах существует нехватка более 150 тысяч специалистов в области data science3. В отчете IBM, Burning Glass Technologies и Business-Higher Education Forum за 2017 года говорится, что к 2020 году в Соединенных Штатах будут существовать сотни тысяч вакансий, требующих квалификации в области data science4.

• По данным статьи AnalyticsWeek за март 2016 года, в течение 5 лет к интернету будет подключено более 50 миллиардов устройств, а к 2020 году в мире будет ежесекундно производиться 1,7 мегабайт новых данных на каждого человека8!

В 2011 году Глобальный институт McKinsey опубликовал отчет «Большие данные: новый рубеж для инноваций, конкуренции и производительности». В отчете было сказано: «Только Соединенные Штаты сталкиваются с нехваткой от 140 тысяч до 190 тысяч специалистов, обладающих глубокими аналитическими познаниями, а также 1,5 миллиона менеджеров и аналитиков, которые бы анализировали большие данные и принимали решения на основании полученных результатов»2. Такое положение дел сохраняется. В отчете за август 2018 года «LinkedIn Workforce Report» сказано, что в Соединенных Штатах существует нехватка более 150 тысяч специалистов в области data science3. В отчете IBM, Burning Glass Technologies и Business-Higher Education Forum за 2017 года говорится, что к 2020 году в Соединенных Штатах будут существовать сотни тысяч вакансий, требующих квалификации в области data science4.

• По данным IBM (ноябрь 2016 года), 90% мировых данных было создано за последние два года7. Факты показывают, что скорость создания данных стремительно растет.

• Визуализации чрезвычайно важны при работе с большими данными: они упрощают исследование данных и получение воспроизводимых результатов исследований, когда количество элементов данных может достигать миллионов, миллиардов и более. Часто говорят, что одна картинка стоит тысячи слов5 — в мире больших данных визуализация может стоить миллиардов, триллионов и даже более записей в базе данных. Визуализации позволяют взглянуть на данные «с высоты птичьего полета», увидеть их «в перспективе» и составить о них представление. Описательные статистики полезны, но иногда могут увести в ошибочном направлении. Например, квартет Энскомба6 демонстрирует посредством визуализаций, что серьезно различающиеся наборы данных могут иметь почти одинаковые показатели описательной статистики.

«Jupyter стал фактическим стандартом для научных исследований и анализа данных. Вычисления упаковываются вместе с аргументами, позволяя вам строить “вычислительные нарративы”; …это упрощает проблему распространения работоспособного кода между коллегами и участниками сообщества»9.

В 2011 году Глобальный институт McKinsey опубликовал отчет «Большие данные: новый рубеж для инноваций, конкуренции и производительности». В отчете было сказано: «Только Соединенные Штаты сталкиваются с нехваткой от 140 тысяч до 190 тысяч специалистов, обладающих глубокими аналитическими познаниями, а также 1,5 миллиона менеджеров и аналитиков, которые бы анализировали большие данные и принимали решения на основании полученных результатов»2. Такое положение дел сохраняется. В отчете за август 2018 года «LinkedIn Workforce Report» сказано, что в Соединенных Штатах существует нехватка более 150 тысяч специалистов в области data science3. В отчете IBM, Burning Glass Technologies и Business-Higher Education Forum за 2017 года говорится, что к 2020 году в Соединенных Штатах будут существовать сотни тысяч вакансий, требующих квалификации в области data science4.

• Визуализации чрезвычайно важны при работе с большими данными: они упрощают исследование данных и получение воспроизводимых результатов исследований, когда количество элементов данных может достигать миллионов, миллиардов и более. Часто говорят, что одна картинка стоит тысячи слов5 — в мире больших данных визуализация может стоить миллиардов, триллионов и даже более записей в базе данных. Визуализации позволяют взглянуть на данные «с высоты птичьего полета», увидеть их «в перспективе» и составить о них представление. Описательные статистики полезны, но иногда могут увести в ошибочном направлении. Например, квартет Энскомба6 демонстрирует посредством визуализаций, что серьезно различающиеся наборы данных могут иметь почти одинаковые показатели описательной статистики.

Приступая к работе

От издательства

Некоторые иллюстрации для лучшего восприятия нужно смотреть в цветном варианте. Мы снабдили их QR-кодами, перейдя по которым, вы можете ознакомиться с цветной версией рисунка.

Ваши замечания, предложения, вопросы отправляйте по адресу comp@piter.com (издательство «Питер», компьютерная редакция). Мы будем рады узнать ваше мнение!

На веб-сайте издательства www.piter.com вы найдете подробную информацию о наших книгах.

В этом разделе собрана информация, которую следует просмотреть перед чтением книги. Обновления будут публиковаться на сайте http://www.deitel.com.

Загрузка примеров кода

Файл examples.zip с кодом примеров книги можно загрузить на нашей веб-странице книги на сайте:

Щелкните на ссылке Download Examples, чтобы сохранить файл на вашем компьютере. Многие браузеры помещают загруженный файл в папку Downloads вашей учетной записи. Когда загрузка завершится, найдите файл в своей системе и распакуйте папку examples в папку Documents вашей учетной записи:

• Windows: C:\Users\YourAccount\Documents\examples

• macOS или Linux: ~/Documents/examples

В большинстве операционных систем имеется встроенная программа распаковки архивов. Также можно воспользоваться внешней программой-архиватором — например, 7-Zip (www.7-zip.org) или WinZip (www.winzip.com).

Структура папки examples

В этой книге приводятся примеры трех типов:

• отдельные фрагменты кода для интерактивной среды IPython;

• законченные приложения, называемые сценариями;

• документы Jupyter Notebook — удобной интерактивной среды для браузера, в которой можно писать и выполнять код, а также чередовать код с текстом, графикой и видео.

Все варианты продемонстрированы в примерах из раздела 1.5.

Каталог examples содержит одну вложенную папку для каждой главы. Этим папкам присвоены имена вида ch##, где ## — двузначный номер главы от 01 до 16 — например, ch01. Кроме глав 13, 15 и 16, папка каждой главы содержит следующие элементы:

• snippets_ipynb — папка с файлами Jupyter Notebook этой главы;

• snippets_py — папка с файлами с исходным кодом Python, в которых хранятся все представленные фрагменты кода, разделенные пустой строкой. Вы можете скопировать эти фрагменты в IPython или в созданные вами новые документы Jupyter Notebook;

• файлы сценариев и используемые ими файлы.

Глава 13 содержит одно приложение. Главы 15 и 16 объясняют, где найти нужные файлы в папках ch15 и ch16 соответственно.

Установка Anaconda

В книге используется дистрибутив Anaconda Python, отличающийся простотой установки. В него входит практически все необходимое для работы с примерами, в том числе:

• интерпретатор IPython;

• большинство библиотек Python и data science, используемых в книге;

• локальный сервер Jupyter Notebook для загрузки и выполнения документов;

• другие программные пакеты, такие как Spyder IDE (Integrated Development Environment), — в книге используются только среды IPython и Jupyter Notebook.

Программу установки Python 3.x Anaconda для Windows, macOS и Linux можно загрузить по адресу:

https://www.anaconda.com/download/

Когда загрузка завершится, запустите программу установки и выполните инструкции на экране. Чтобы установленная копия Anaconda работала правильно, не перемещайте ее файлы после установки.

Обновление Anaconda

Затем проверьте актуальность установки Anaconda. Откройте окно командной строки в своей системе:

• В macOS откройте приложение Terminal из подкаталога Utilities в каталоге Applications.

• В Windows откройте командную строку Anaconda Prompt из меню Пуск. Когда вы делаете это для обновления Anaconda (как в данном случае) или для установки новых пакетов (см. ниже), выполните Anaconda Prompt с правами администратора: щелкните правой кнопкой мыши и выберите команду Запуск от имени администратора. (Если вы не можете найти команду Anaconda Prompt в меню Пуск, найдите ее при помощи поля поиска в нижней части экрана.)

• В Linux откройте терминал или командную оболочку своей системы (зависит от дистрибутива Linux).

В окне командной строки своей системы выполните следующие команды, чтобы обновить установленные пакеты Anaconda до последних версий:

conda update conda

conda update --all

Менеджеры пакетов

Приведенная выше команда conda запускает менеджер пакетов conda — один из двух основных менеджеров пакетов Python, используемых в книге (другой — pip). Пакеты содержат файлы, необходимые для установки отдельных библиотек или инструментов Python. В книге conda будет использоваться для установки дополнительных пакетов, если только не окажется, что эти пакеты недоступны в conda; в этом случае будет использоваться pip. Некоторые разработчики предпочитают пользоваться исключительно pip, потому что эта программа в настоящее время поддерживает больше пакетов. Если у вас возникнут проблемы с установкой пакетов из conda, попробуйте использовать pip.

Установка программы статического анализа кода Prospector

Для анализа кода Python можно воспользоваться аналитической программой Prospector, которая проверяет ваш код на наличие типичных ошибок и помогает улучшить его. Чтобы установить программу Prospector и используемые ею библиотеки Python, выполните следующую команду в окне командной строки:

pip install prospector

Установка jupyter-matplotlib

В книге для построения некоторых анимаций используется библиотека визуализации Matplotlib. Чтобы использовать анимации в документах Jupyter Notebook, необходимо установить программу ipympl. В терминале в командной строке Anaconda или в оболочке, открытой ранее, последовательно выполните следующие команды19:

conda install -c conda-forge ipympl

conda install nodejs

jupyter labextension install @jupyter-widgets/jupyterlab-manager

jupyter labextension install jupyter-matplotlib

Установка других пакетов

Дистрибутив Anaconda включает приблизительно 300 популярных пакетов Python и data science, включая NumPy, Matplotlib, pandas, Regex, BeautifulSoup, requests, Bokeh, SciPy, SciKit-Learn, Seaborn, Spacy, sqlite, statsmodels и многие другие. Количество дополнительных пакетов, которые вам придется устанавливать в книге, будет небольшим, и мы будем приводить инструкции по установке в таких местах. В документации новых пакетов объясняется, как их следует устанавливать.

Получение учетной записи разработчика Twitter

Если вы намереваетесь использовать главу «Глубокий анализ данных Twitter» и все примеры на базе Twitter в последующих главах, подайте заявку на получение учетной записи разработчика Twitter. Сейчас Twitter требует регистрации для получения доступа к их API. Чтобы подать заявку на создание учетной записи разработчика, заполните и отправьте форму по адресу:

https://developer.twitter.com/en/apply-for-access

Twitter проверяет каждую заявку. На момент написания книги заявки на создание личных учетных записей разработчиков утверждались практически немедленно, а на утверждение заявок от компаний требовалось от нескольких дней до нескольких недель. Успешное утверждение не гарантировано.

Необходимость подключения к интернету в некоторых главах

При использовании этой книги вам может понадобиться подключение к интернету для установки дополнительных библиотек. В некоторых главах вы будете регистрироваться для создания учетных записей в облачных сервисах (в основном для использования их бесплатных уровней). Некоторые сервисы требуют кредитных карт для подтверждения личности. В отдельных случаях будут использоваться платные сервисы. Тогда мы воспользуемся кредитом, который предоставляется фирмой-поставщиком, так что вы сможете опробовать сервис без каких-либо затрат. Предупреждение: некоторые облачные сервисы начинают выставлять счета после их настройки. Когда вы закончите анализ примеров с использованием таких сервисов, без промедления удалите выделенные ресурсы.

Различия в выводе программ

При выполнении наших примеров вы можете заметить некоторые различия между приведенными и вашими результатами:

• Из-за различий в выполнении вычислений в формате с плавающей точкой (например, –123.45, 7.5 или 0.0236937) в разных операционных системах вы можете заметить незначительные различия в выводе, особенно в младших разрядах дробной части.

• Когда мы приводим выходные данные, отображаемые в разных окнах, мы обрезаем границы окон для экономии места.

Получение ответов на вопросы

На форумах в интернете вы сможете общаться с другими программистами Python и получать ответы на свои вопросы. Некоторые популярные форумы по тематике Python и программирования в целом:

• python-forum.io

• StackOverflow.com

• https://www.dreamincode.net/forums/forum/29-python/

Кроме того, многие фирмы-разработчики предоставляют форумы, посвященные их инструментам и библиотекам. Управление большинством упоминаемых в книге библиотек и их сопровождение осуществляется на github.com. Некоторые разработчики, занимающиеся сопровождением библиотек, предоставляют поддержку на вкладке Issues страницы GitHub библиотеки. Если вам не удастся найти ответ на свой вопрос в интернете, обращайтесь к веб-странице книги на сайте20

Теперь все готово к чтению книги. Надеемся, она вам понравится!

20 В настоящее время наш сайт проходит глобальную реконструкцию. Если вы не найдете какую-то необходимую информацию, напишите нам по адресу deitel@deitel.com.

В настоящее время наш сайт проходит глобальную реконструкцию. Если вы не найдете какую-то необходимую информацию, напишите нам по адресу deitel@deitel.com.

Глава 1. Компьютеры и Python

В этой главе…

• Наиболее интересные тенденции в области современных вычислительных технологий.

• Краткий обзор основ объектно-ориентированного программирования.

• Сильные стороны Python.

• Знакомство с важнейшими библиотеками Python и data science, используемыми в этой книге.

• Интерактивный режим интерпретатора IPython и выполнение кода Python.

• Выполнение сценария Python для анимации гистограммы.

• Создание и тестирование веб-оболочки Jupyter Notebook для выполнения кода Python.

• Большие данные: с каждым днем еще больше.

• Анализ больших данных на примере популярного мобильного навигационного приложения.

• Искусственный интеллект: пересечение компьютерной теории и data science.

1.1. Введение

Знакомьтесь: Python — один из наиболее широко используемых языков программирования, а согласно индексу PYPL (Popularity of Programming Languages) — самый популярный в мире21.

В этом разделе представлены терминология и концепции, закладывающие основу для программирования на языке Python, которому будут посвящены главы 2–10, и для практических примеров из области больших данных, искусственного интеллекта и облачных технологий, описываемых в главах 11–16.

Читатели узнают, почему язык Python стал таким популярным, познакомятся со стандартной библиотекой Python и различными библиотеками data science, благодаря которым не придется заново «изобретать велосипед». Эти библиотеки используются для создания объектов. С их помощью можно решать серьезные задачи при умеренном объеме программного кода.

Затем будут рассмотрены три примера, демонстрирующие различные способы выполнения кода Python:

• В первом примере вы будете выполнять команды Python в оболочке IPython в интерактивном режиме и сразу же видеть результаты.

• Во втором примере мы выполним серьезное приложение Python, отображающее анимированную гистограмму результатов бросков шестигранного кубика. Это позволит увидеть «закон больших чисел» в действии. Забегая чуть вперед, отметим, что в главе 6 это же приложение будет построено с использованием библиотеки визуализации Matplotlib.

• В последнем примере будет продемонстрирована работа с документами Jupyter Notebook с использованием JupyterLab — интерактивной оболочки на базе веб-браузера, обеспечивающей удобство в процессе формирования и выполнения инструкции Python. К слову, в документы Jupyter Notebook можно включать текст, изображения, звуковые данные, видеоролики, анимации и программный код.

В прошлом большинство компьютерных приложений выполнялось на автономных (то есть не объединенных в сеть) компьютерах. Современные приложения могут создаваться с расчетом на взаимодействие с миллиардами компьютеров по всему мире через интернет. Мы расскажем об облачных технологиях и концепции IoT (Internet of Things), закладывающих основу для современных приложений (подробнее об этом в главах 11–16).

Вы, кроме того, узнаете, насколько велики большие данные и как они стремительно становятся еще больше. Затем будет представлен вариант анализа больших данных на примере мобильного навигационного приложения Waze. Это приложение многие современные технологии использует для построения динамических инструкций, помогающих быстро и безопасно добраться до конечной точки маршрута. При описании этих технологий будет указано, где многие из них используются в этой книге. Глава завершается разделом «Введение в data science», посвященным важнейшей области пересечения компьютерной теории и дисциплины data science — искусственному интеллекту.

1.2. Основы объектных технологий

Потребность в новых, более мощных программах стремительно растет, поэтому очень важно, чтобы программные продукты строились по возможности быстро, корректно и эффективно. Объекты (точнее, классы, на основе которых строятся объекты), по сути, представляют собой программные компоненты, пригодные для повторного использования. Объектом может быть что угодно: дата, время, аудио, видео, автомобиль, человек и т.д. Практически каждое существительное может быть адекватным образом представлено программным объектом, обладающим атрибутами (например, имя, цвет и размер) и способностями к выполнению определенных действий (например, вычисление, перемещение и обмен данными). Разработчики программ используют модульную структуру и объектно-ориентированную методологию проектирования с большей эффективностью, чем некогда популярные методологии вроде «структурного программирования». Объектно-ориентированные программы зачастую более понятны, их проще исправлять и модифицировать.

Автомобиль как объект

Чтобы лучше понять суть объектов и их внутреннее устройство, воспользуемся простой аналогией. Представьте, что вы ведете автомобиль и нажимаете педаль газа, чтобы набрать скорость. Но что должно произойти до того, как вы получите возможность водить автомобиль? Прежде всего автомобиль нужно изготовить. Изготовление любого автомобиля начинается с инженерных чертежей (калек), подробно описывающих устройство автомобиля. На этих чертежах даже показано устройство педали акселератора. За этой педалью скрываются сложные механизмы, которые при приведении в действие ускоряют автомобиль. Аналогично и педаль тормоза «скрывает» механизмы, тормозящие автомобиль, руль «скрывает» механизмы, поворачивающие автомобиль, и т.д. Благодаря этому люди, не имеющие понятия о внутреннем устройстве автомобиля, могут легко им управлять.

Невозможно готовить пищу на кухне, существующей лишь на листе бумаги; точно так же нельзя водить автомобиль, существующий лишь в чертежах. Прежде чем вы сядете за руль машины, ее нужно воплотить в металл на основе чертежей. Воплощенный в металле автомобиль имеет реальную педаль газа, с помощью которой он может ускоряться, но (к счастью!) не может делать это самостоятельно — нажимает на педаль газа водитель.

Методы и классы

Воспользуемся примером с автомобилем для иллюстрации некоторых ключевых концепций объектно-ориентированного программирования. Для выполнения задачи в программе требуется метод, «скрывающий» инструкции программы, которые фактически выполняют задание. Метод скрывает эти инструкции от пользователя подобно тому, как педаль газа автомобиля скрывает от водителя механизмы, вызывающие ускорение автомобиля. В Python программная единица, именуемая классом, включает методы, выполняющие задачи класса. Например, класс, представляющий банковский счет, может включать три метода, один из которых выполняет пополнение счета, второй — вывод средств со счета, а третий — запрос текущего баланса. Класс напоминает концепцию автомобиля, представленного чертежами, включая чертежи педали газа, рулевого колеса и других механизмов.

Создание экземпляра класса

Итак, чтобы управлять автомобилем, его сначала необходимо изготовить по чертежам; точно так же перед выполнением задач, определяемых методами этого класса, сначала необходимо создать объект класса. Этот процесс называется созданием экземпляра. Полученный при этом объект называется экземпляром класса.

Повторное использование

Подобно тому как один и тот же чертеж можно повторно использовать для создания многих автомобилей, один класс можно повторно использовать для создания многих объектов. Повторное использование существующих классов при построении новых классов и программ экономит время и силы разработчика, облегчает создание более надежных и эффективных систем, поскольку ранее созданные классы и компоненты прошли тщательное тестирование, отладку и оптимизацию производительности. Подобно тому как концепция взаимозаменяемых частей легла в основу индустриальной революции, повторно используемые классы — двигатель прогресса в области создания программ, который был вызван внедрением объектной технологии.

В Python для создания программ обычно применяется принцип компоновки из готовых блоков. Дабы заново не «изобретать велосипед», используйте качественные готовые компоненты там, где это возможно. Повторное использование программного кода — важнейшее преимущество объектно-ориентированного программирования.

Сообщения и вызовы методов

Нажимая педаль газа, вы тем самым отсылаете автомобилю сообщение с запросом на выполнение определенной задачи (ускорение движения). Подобным же образом отсылаются и сообщения объекту. Каждое сообщение реализуется вызовом метода, который «сообщает» методу объекта о необходимости выполнения определенной задачи. Например, программа может вызвать метод deposit объекта банковского счета для его пополнения.

Атрибуты и переменные экземпляра класса

Любой автомобиль не только способен выполнять определенные задачи, но и обладает и характерными атрибутами: цвет, количество дверей, запас топлива в баке, текущая скорость и пройденное расстояние. Атрибуты автомобиля, как и его возможности по выполнению определенных действий, представлены на инженерных диаграммах как часть проекта (например, им могут соответствовать одометр и указатель уровня бензина). При вождении автомобиля его атрибуты существуют вместе с ним. Каждому автомобилю присущ собственный набор атрибутов. Например, каждый автомобиль «знает» о том, сколько бензина осталось в его баке, но ему ничего не известно о запасах горючего в баках других автомобилей.

Объект, как и автомобиль, имеет собственный набор атрибутов, которые он «переносит» с собой при использовании этого объекта в программах. Эти атрибуты определены в качестве части объекта класса. Например, объект банковского счета bank-account имеет атрибутбаланса, представляющий количество средств на банковском счете. Каждый объект bank-account «знает» о количестве средств на собственном счете, но ничего не «знает» о размерах других банковских счетов. Атрибуты определяются с помощью других переменных экземпляра класса. Между атрибутами и методами класса (и его объектов) существует тесная связь, поэтому классы хранят вместе свои атрибуты и методы.

Наследование

С помощью наследования можно быстро и просто создать новый класс объектов. При этом новый класс (называемый подклассом) наследует характеристики существующего класса (называемого суперклассом) — возможно, частично изменяя их или добавляя новые характеристики, уникальные для этого класса. Если вспомнить аналогию с автомобилем, то «трансформер» является объектом более обобщенного класса «автомобиль» с конкретной особенностью: у него может подниматься или опускаться крыша.

Объектно-ориентированный анализ и проектирование

Вскоре вы начнете писать программы на Python. Как же вы будете формировать код своих программ? Скорее всего, как и большинство других программистов, вы включите компьютер и начнете вводить с клавиатуры исходный код программы. Подобный подход годится при создании маленьких программ (вроде тех, что представлены в начальных главах книги), но что делать при создании крупного программного комплекса, который, например, управляет тысячами банкоматов крупного банка? А если вы руководите командой из 1000 программистов, занятых разработкой системы управления воздушным движением следующего поколения? В таких крупных и сложных проектах нельзя просто сесть за компьютер и строка за строкой вводить код.

Чтобы выработать наилучшее решение, следует провести процесс детального анализатребований к программному проекту (то есть определить, что должна делать система) и разработать проектное решение, которое будет соответствовать этим требованиям (то есть определить, как система будет выполнять поставленные задачи). В идеале вы должны тщательно проанализировать проект (либо поручить выполнение этой задачи коллегам-профессионалам) еще до написания какого-либо кода. Если этот процесс подразумевает применение объектно-ориентированного подхода, то, значит, мы имеем дело с процессомOOAD (object-oriented analysis and design, объектно-ориентированный анализ и проектирование). Языки программирования, подобные Python, тоже называются объектно-ориентированными. Программирование на таком языке — объектно-ориентированное программирование (ООП) — позволяет реализовать результат объектно-ориентированного проектирования в форме работоспособной системы.

1.3. Python

Python — объектно-ориентированный сценарный язык, официально опубликованный в 1991 году. Он был разработан Гвидо ван Россумом (Guido van Rossum) из Национального исследовательского института математики и компьютерных наук в Амстердаме.

Python быстро стал одним из самых популярных языков программирования в мире. Он пользуется особой популярностью в среде образования и научных вычислений22, а в последнее время превзошел язык программирования R в качестве самого популярного языка обработки данных23,24,25. Назовем основные причины популярности Python, пояснив, почему каждому стоит задуматься об изучении этого языка26,27,28:

• Python — бесплатный общедоступный проект с открытым кодом, имеющий огромное сообщество пользователей.

• Он проще в изучении, чем такие языки, как C, C++, C# и Java, что позволяет быстро включиться в работу как новичкам, так и профессиональным разработчикам.

• Код Python проще читается, чем большинство других популярных языков программирования.

• Он широко применяется в образовательной области29.

• Он повышает эффективность труда разработчика за счет обширной подборки стандартных и сторонних библиотек с открытым кодом, так что программисты могут быстрее писать код и решать сложные задачи с минимумом кода (подробнее см. раздел 1.4).

• Существует множество бесплатных приложений Python с открытым кодом.

• Python — популярный язык веб-разработки (Django, Flask и т.д.).

• Он поддерживает популярные парадигмы программирования — процедурную, функциональную и объектно-ориентированную30. Обратите внимание: мы начнем описывать средства функционального программирования в главе 4, а потом будем использовать их в последующих главах.

• Он упрощает параллельное программирование — с asyncio и async/await вы можете писать однопоточный параллельный код31, что существенно упрощает сложные по своей природе процессы написания, отладки и сопровождения кода32.

• Существует множество возможностей для повышения быстродействия программ на языке Python.

• Python используется для построения любых программ от простых сценариев до сложных приложений со множеством пользователей, таких как Dropbox, YouTube, Reddit, Instagram или Quora33.

• Python — популярный язык для задач искусственного интеллекта, а эта область в последнее время стремительно развивается (отчасти благодаря ее особой связи с областью data science).

• Он широко используется в финансовом сообществе34.

• Для программистов Python существует обширный рынок труда во многих областях, особенно в должностях, связанных с data science, причем вакансии Python входят в число самых высокооплачиваемых вакансий для программистов35,36. Ближайший конкурент Python — R, популярный язык программирования с открытым кодом для разработки статистических приложений и визуализации. Сейчас Python и R — два наиболее широко применяемых языка data science.

Anaconda

Мы будем использовать дистрибутив Python Anaconda — он легко устанавливается в Windows, macOS и Linux, поддерживая последние версии Python, интерпретатора IPython (раздел 1.5.1) и Jupyter Notebooks (раздел 1.5.3). Anaconda также включает другие программные пакеты и библиотеки, часто используемые в программировании Python и data science, что позволяет разработчикам сосредоточиться на коде Python и аспектах data science, не отвлекаясь на возню с проблемами установки. Интерпретатор IPython37 обладает интересными возможностями, позволяющими проводить исследования и эксперименты с Python, стандартной библиотекой Python и обширным набором сторонних библиотек.

Дзен Python

Мы придерживаемся принципов из статьи Тима Петерса (Tim Peters) «The Zen of Python», в которой приведена квинтэссенция идеологии проектирования от создателя Python Гвидо ван Россума. Этот список также можно просмотреть в IPython, воспользовавшись командой import this. Принципы «дзена Python» определяются в предложении об улучшении языка Python (PEP, Python Enhancement Proposal) 20, согласно которому «PEP — проектный документ с информацией для сообщества Python или с описанием новой возможности Python, его процессов или окружения»38.

1.4. Библиотеки

В этой книге мы будем по возможности пользоваться существующими библиотеками (включая стандартные библиотеки Python, библиотеки data science и некоторые сторонние библиотеки) — их применение способствует повышению эффективности разработки программных продуктов. Так, вместо того чтобы писать большой объем исходного кода (дорогостоящий и длительный процесс), можно просто создать объект уже существующего библиотечного класса посредством всего одной команды Python. Библиотеки позволяют решать серьезные задачи с минимальным объемом кода.

1.4.1. Стандартная библиотека Python

Стандартная библиотека Python предоставляет богатую функциональность обработки текстовых/двоичных данных, математических вычислений, программирования в функциональном стиле, работы с файлами/каталогами, хранения данных, сжатия/архивирования данных, криптографии, сервисных функций операционной системы, параллельного программирования, межпро цессных взаимодействий, сетевых протоколов, работы с JSON/XML/другими форматами данных в интернете, мультимедиа, интернационализации, построения графического интерфейса, отладки, профилирования и т.д. В таблице выше перечислены некоторые модули стандартной библиотеки Python, которые будут использоваться в примерах.

| Некоторые модули стандартной библиотеки Python, используемые в книге |

| collections — дополнительные структуры данных помимо списков, кортежей, словарей и множеств. csv — обработка файлов с данными, разделенными запятыми. datetime, time — операции с датой и временем. decimal — вычисления с фиксированной и плавающей точкой, включая финансовые вычисления. doctest — простое модульное тестирование с использованием проверочных тестов и ожидаемых результатов, закодированных в doc-строках. json — обработка формата JSON (JavaScript Object Notation) для использования с веб-сервисами и базами данных документов NoSQL. math — распространенные математические константы и операции. os — взаимодействие с операционной системой. queue — структура данных, работающая по принципу «первым зашел, первым вышел» (FIFO). random — псевдослучайные числа. re — регулярные выражения для поиска по шаблону. sqlite3 — работа с реляционной базой данных SQLite. statistics — функции математической статистики (среднее, медиана, дисперсия, мода и т.д.). string — обработка строк. sys — обработка аргументов командной строки; потоки стандартного ввода, стандартного вывода; стандартный поток ошибок. timeit — анализ быстродействия. |

1.4.2. Библиотеки data science